Trois fronts sont ouverts : l’astronomie, l’exploration robotique et l’exploration habitée ; et nous devons prendre en compte trois contraintes : notre capacité technologique, nos possibilités biologiques et notre capacité financière (cette dernière n’étant pas la moindre).

Dans toutes les hypothèses nous devons voir et aller, aussi loin qu’il nous est possible. Ce principe est évidemment subjectif et discutable mais il est partagé par beaucoup d’hommes sur Terre. D’autres peuvent se contenter de rechercher le confort matériel, pour eux-mêmes, pour leur proches ou pour l’humanité, ou bien leur épanouissement ici et maintenant sur Terre ; d’autres encore pensent avant tout à leur salut spirituel et peu leur importe sur quel sol ils se trouvent. Je fais partie de ceux qui ont soif de voyages, de lointain, de découvertes, d’aventures et de compréhension scientifique du monde.

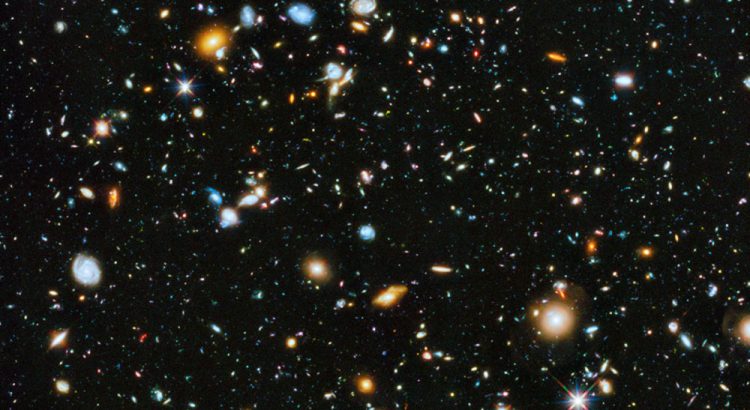

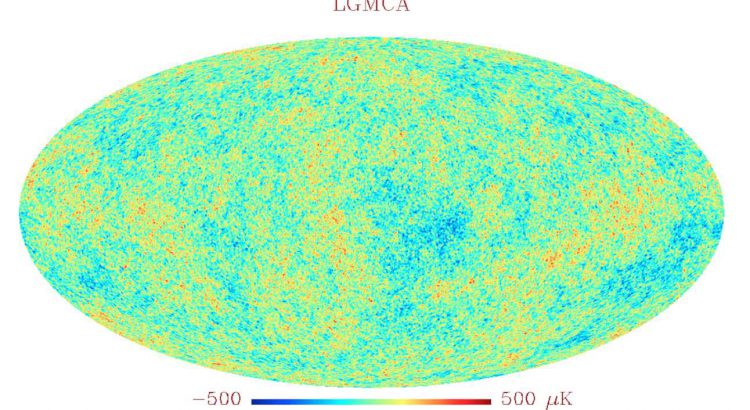

Dans cet esprit, moi et mes semblables (du moins je l’espère !) désirons que l’exploration spatiale soit une priorité de nos contemporains (personnes privées ou publiques), que la recherche astronomique développe sa puissance de « vision » vers l’aube de l’Univers (pour mieux comprendre la formation des galaxies et des premières étoiles), vers le centre galactique (pour mieux comprendre le fonctionnement des trous noirs), vers les étoiles voisines (pour tenter de trouver une planète rocheuse dotée d’une atmosphère transformée par la vie, dans sa zone habitable), vers les confins du système solaire et en particulier vers la mystérieuse « Neuvième-Planète » tapie dans les ténèbres sur une orbite extrêmement lointaine et excentrée (pour tout connaître de notre système solaire).

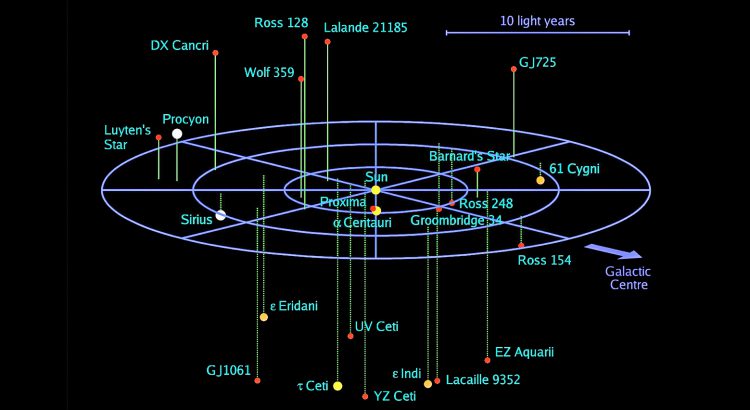

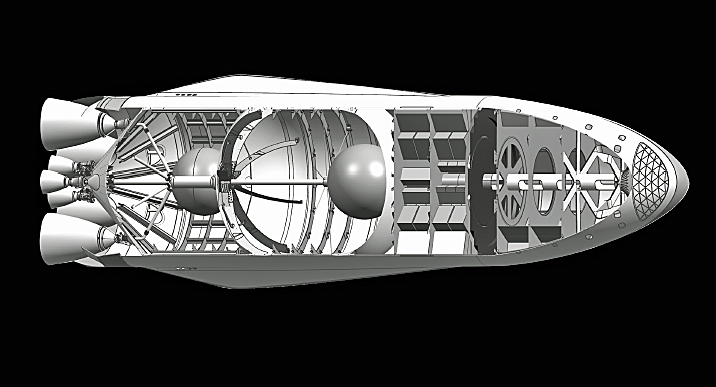

A cette distance on entre dans la zone frontière entre l’astronomie et de l’astronautique puisque, si on découvre cette Neuvième-Planète avec nos télescopes, il faudra évidemment l’étudier (et si possible y aller !) pour savoir quelles sont ses caractéristiques géomorphiques et comment elle s’est formée. La recherche astronautique doit donc, dans le domaine des missions robotiques, continuer à explorer le système solaire plus loin que l’homme ne peut aller aujourd’hui mais aussi en précurseur des missions habitées d’après demain. Il faudra développer sur le plan pratique les technologies déjà imaginées et théorisées qui permettront un accès suffisamment rapide aux endroits les plus éloignés. Ainsi, la propulsion photonique nous permettra de bénéficier d’impulsions longues, donnant une accélération continue qui assez rapidement (dans le domaine d’irradiance forte du système, entre 0,1 UA et 1,5 UA ou à partir de la Terre avec des lasers) générera pour des masses faibles, des vitesses de plusieurs pour cent de celle de la lumière (que l’on conservera, même éloignés de la source de lumière puisque le seul frein dans l’espace du système solaire est la gravité – faible – du soleil). Nous pourrons ainsi, avec peu de masse (pour disposer de suffisamment d’énergie), explorer les systèmes stellaires les plus proches (à l’intérieur d’une sphère d’une dizaine d’années lumières) comme le veulent les promoteurs du projet « Breakthrough Starshot » mais aussi les planètes lointaines de notre système comme la Neuvième-Planète déjà citée.

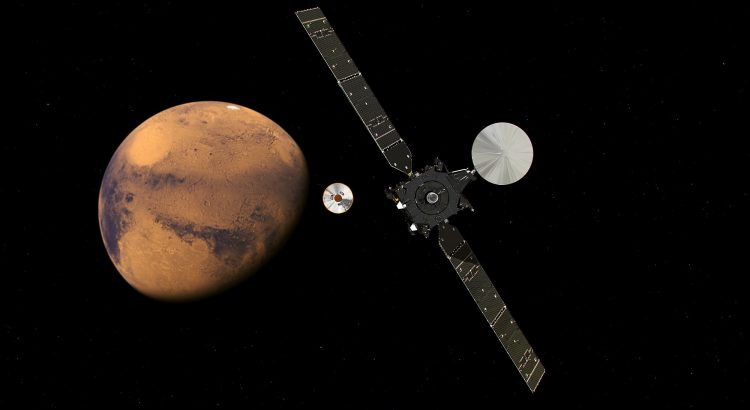

Pour ce qui est des autres planètes du système solaire (plus proches) on peut toujours recourir aux moteurs à propulsion chimique comme on l’a fait jusqu’à présent ou encore aux moteurs utilisant l’énergie nucléaire (une fois placé en orbite terrestre par propulsion chimique !) ou peut-être un jour à la propulsion électromagnétique (« EmDrive »), encore mal comprise mais prometteuse…si elle s’avère possible. Il faut retourner sur Titan pour analyser son écosystème et voir jusqu’où le processus prébiotique a pu évoluer dans sa complexification. Il faut se poser sur Europa ou Encelade et forer dans la glace pour atteindre l’eau de l’océan sous-jacent. Enfin il faut aller sur Mars au plus vite pour y initier une installation permanente puisque Mars est la seule planète de notre environnement spatial où cette installation permettra à l’homme de vivre continûment en dehors de la Terre.

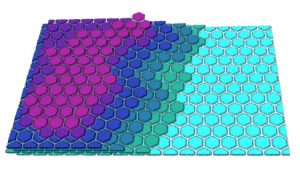

Ces divers fronts d’exploration s’épauleront les uns les autres. Plus nous enverrons de vaisseaux dans l’espace, moins ils coûteront cher. Pour voir vraiment loin, nous devrons développer l’interférométrie optique et radio dans l’espace, en complément des grands observatoires en réseau que nous développons sur Terre. Des champs de télescopes flottant dans l’espace regardant ensemble et en même temps, la même source lumineuse (ou électromagnétique) et concentrant l’information dans un centre commun à égale distance de tous (ou corrigeant électroniquement les différences de distance, donc de temps). Ces télescopes nous pourrons les placer au point de Lagrange L2 (dans l’ombre de la Terre par rapport au Soleil), puis ailleurs dans l’espace. On peut aussi imaginer faire de l’interférométrie avec des télescopes situés en L2 et en L3 (de l’autre côté du Soleil), déterminant ensemble un gigantesque réceptacle des diverses sources de lumière de l’Univers (d’un diamètre de plus de deux fois la distance de la Terre au soleil).

Nous sommes devenus adultes et nous étouffons dans notre maison d’enfance devenue trop petite. Ne tournons plus en rond dans le jardin. Nous nous sommes suffisamment exercés dans la Station Spatiale Internationale dans laquelle on ne peut même pas tester la gravité artificielle pourtant indispensable pour aller physiquement plus loin ; la Lune, trop proche et déjà vue, doit être sortie du programme ! Il nous faut partir pour aller « ailleurs ».

Image à la Une: Nos plus proches voisines, les étoiles se trouvant dans un rayon de 10 années lumière du Soleil (La Voie Lactée a un rayon de quelques 60.000 années lumière). Ce sont les seules que l’on peut aujourd’hui imaginer pouvoir atteindre par un moyen astronautique. Crédit R. Powell.