CHEOPS ( CHaracterizing ExOPlanet Satellite) sera la première mission dédiée à la caractérisation des exoplanètes proches déjà repérées. C’est une entreprise dirigée par l’Université de Berne dans le cadre de l’ESA au travers du Swiss Space Office. La réalisation de la charge scientifique, le télescope et ses annexes, a été terminée en avril ; elle est maintenant en Espagne pour montage sur la plateforme du satellite ; le lancement doit avoir lieu début 2019 en Guyane.

Avec CHEOPS il ne s’agit pas de découvrir de nouvelles exoplanètes mais, connaissant leur masse par la méthode dite de la « vitesse radiale » de leur étoile (déplacement de l’étoile du fait de sa relation gravitationnelle avec sa ou ses planètes), de déterminer leur volume (via leur diamètre) par mesure aussi précise que possible de leur « profondeur de transit » en utilisant la méthode dite « des transits » (c’est-à-dire l’intensité d’obscuration de la lumière de l’étoile causée par leur passage devant l’étoile). Connaissant le volume et la masse d’une planète, on peut en déduire sa densité et donc dans une certaine mesure sa composition en prenant en compte sa proximité à l’étoile (donc sa température). La différenciation entre roche et atmosphère peut être renforcée par l’observation de la « modulation » de la lumière lorsque la planète est éclairée par son étoile avant de passer derrière elle ou encore la disparition de la planète derrière l’étoile peut permettre de déduire l’émission thermique propre à la planète, donc son spectre d’émission.

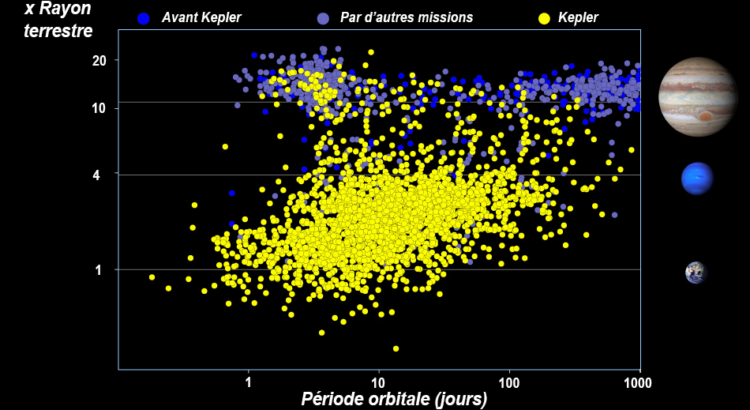

CHEOPS doit étudier les planètes identifiées comprises entre un et six diamètres terrestres dans des systèmes dont l’étoile a une magnitude visuelle (« V ») allant de 6 à 12 (pour comparaison l’œil peut discerner les objets jusqu’à la magnitude 6 et l’observatoire spatial Hipparcos a établi la carte des étoiles allant jusqu’à la magnitude 11). Cela représente une population de 500 à 700 étoiles. CHEOPS est une mission « de suivi » par rapport aux planètes déjà repérées et comme les petites planètes à grande distance de leur étoile ne sont pas encore connues, on ne pourra pratiquement observer que des planètes à périodes orbitales courtes et relativement proches de notre système solaire (jusqu’à quelques centaines de parsec). CHEOPS pourrait mesurer une planète de la taille de la Terre et on en connait quelques-unes mais elles orbitent des étoiles plus petites que notre Soleil (des « naines rouges »). On attend la mission PLATO qui sera lancé en 2026 pour trouver ce type de planète orbitant des étoiles de type solaire.

Tout a commencé en 2012 lorsque l’ESA a lancé un appel d’offres pour les missions « S » (pour Small, à côté de « M » – comme « PLATO » – et « L ») dans le cadre de son programme « Cosmic Vision ». L’idée était de mener des missions peu chères (50 millions d’euros maximum, pour l’ESA) et réalisables en quatre ans maximum (l’équivalent en moins cher des missions « scouts » de la NASA). L’Université de Berne a remporté l’appel d’offre pour la première mission S avec ce concept CHEOPS, devant 25 autres projets. La charge utile, le télescope et ses annexes (qui représente 40 millions d’euros – dont 25 pour la Suisse – sur un total de 100 en prenant en compte les participations non-ESA venant du « Consortium CHEOPS réunissant 11 pays membres de l’ESA sous la direction de la Suisse) a été étudiée et réalisée par le Center of Space and Habitability (CSH) sous la direction de Christopher Broeg (chef de projet), le Professeur Willy Benz, directeur de l’Institut de Physique, étant le responsable de la mission dans son ensemble (« Principal Investigator »). La plateforme, réalisée par Airbus Defense & Space en Espagne, sur laquelle sera monté le télescope, est inspirée de celle de leur satellite SEOSAT (satellite d’observation de la Terre qui doit être lancé également en 2019). Le lancement de CHEOPS était originellement prévu à partir de Kourou en 2017 mais il a été quelque peu retardé (comme la quasi-totalité des projets spatiaux qui posent, pour leur réalisation, des problèmes complexes que l’on ne peut totalement anticiper). Finalement, CHEOPS va être lancé comme un passager secondaire avec un satellite italien d’observation de la terre sur une fusée Soyouz, très vraisemblablement durant la première moitié de 2019.

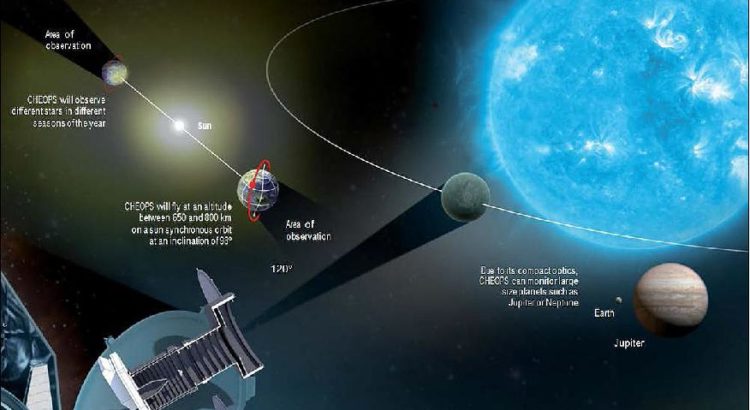

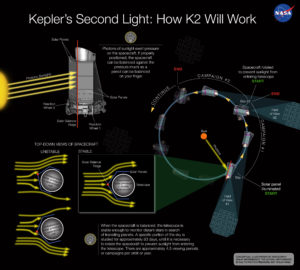

Comme tous les télescopes spatiaux, CHEOPS est une merveille technologique. Il est le résultat de tout un ensemble d’idées originales et souvent « géniales » car on doit toujours envoyer la charge utile la moins massive, la plus adaptée à l’objectif, la plus performante et la plus fiable. Sans tout mentionner on peut par exemple évoquer le positionnement du satellite porteur du télescope. Il sera en rotation autour de la Terre à 700 km d’altitude (environ deux fois l’altitude de l’ISS) sur une orbite héliosynchrone, dans un plan orthogonal à l’éclairage solaire (le plan de l’orbite suivra celui du terminateur terrestre) et tournant toujours l’objectif du télescope dans la direction opposée à la source des rayons solaires, tandis que les panneaux solaires (réalisés en Belgique) fixés sur sa coque extérieure, feront écran et fourniront l’énergie (puissance de 60 W seulement !). Le télescope lui-même est petit, doté d’un miroir (réalisé en Italie) de 32 cm dans un tube de 150 cm (ouverture 30 cm) et il fonctionne en visuel et proche infrarouge (détecteur CCD, longueurs d’ondes entre 0,4 et 1,1 microns). Un dispositif de lentilles défocalise le rayonnement et l’étale sur 765 pixels ce qui permet une analyse plus facile, en définissant un périmètre et une surface soigneusement calibrée à l’Université de Berne. De la même manière l’intensité des signaux reçus par la plaque CCD, des photons convertis en électrons, a fait l’objet d’un calibrage pour pouvoir être proprement interprétée une fois le télescope en fonction. Après le montage en Espagne, il y aura encore des tests thermiques en France, vibratoires à Zurich, acoustiques en Hollande. Pendant le fonctionnement du satellite (la mission doit durer 3,5 ans) le Science Operation Center de la mission sera localisé à l’Université de Genève. NB ce « segment sol » représente 10 millions d’euros (à l’intérieur du total des 100 déjà mentionnés) et la Suisse en prend 5 à sa charge (portant ainsi la dépense totale pour la Confédération, à 30 millions d’euros).

La profondeur des transits des planètes de taille terrestre possibles sera de l’ordre de 100 ppm et la sensibilité des CCD sera de l’ordre de 20 ppm en six heures. Pour les planètes de la taille de Saturne la profondeur des transits attendue sera évidemment beaucoup plus grande (2500 ppm), la sensibilité requise de 85 ppm en 3 heures et la luminosité de l’étoile pourra aller beaucoup plus bas (V de 9 à 12). On a donc là un éventail assez largement ouvert mais il faut noter qu’on ne recherchera pas les mêmes informations venant d’une Saturne ou d’une super-Terre (une super-Terre de la taille de Saturne serait impossible du fait de sa masse et réciproquement), cet éventail est donc bien nécessaire pour couvrir une gamme étendue de planètes proches de leur étoile. D’autant que si on recherche des super-Terres, on cherche aussi à comprendre comment « fonctionnent » les planètes plus grosses dans leur système c’est-à-dire quelle a pu être leur histoire dynamique étant donnée leur présence très près de leur étoile (sur des orbites de courte période) contrairement à ce que l’on constate dans le système solaire.

CHEOPS est une étape. En étudiant les étoiles les plus brillantes on aura des signaux beaucoup plus nets pour une population relativement importante d’étoiles proches, que ceux recueillis par Kepler. On veut aussi grâce à cette mission sélectionner les meilleures cibles pour les caractérisations futures des exoplanètes de la catégorie concernée. Il faut bien voir en effet l’intégration de tous ces projets d’exploration. Un instrument collecte des données qui après analyse sont utilisées par les autres. Dans le cas de CHEOPS, E-ELT et JWST avec leurs outils spectrométriques reprendront les cibles semblant les plus intéressantes.

Lien vers le site CHEOPS de l’Université de Berne :

Le texte de cet article a été soumis pour contrôle au Professeur Willy Benz. Il y a apporté quelques corrections.

Image à la Une : CHEOPS dans son contexte. Crédit Airbus DS.

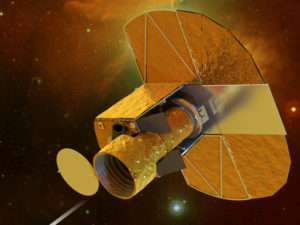

Image ci-dessous : CHEOPS avec ses panneaux solaires déployés (vue d’artiste), crédit Swiss Space Center, EPFL

Image ci-dessous, CHEOPS, dans sa configuration de lancement avec détails de la localisation des équipements (par rapport à l’illustration ci-dessus, les panneaux solaires sont repliés). Crédit ESA.