En 2007 le projet DARWIN d’observation des exoplanètes de taille terrestre par un groupe de télescopes spatiaux interférométriques était abandonné par son promoteur, l’ESA. Aujourd’hui des chercheurs de l’ETH de Zürich mettent en évidence l’intérêt qu’aurait la reprise d’un projet comparable, compte tenu des observations accumulées par la mission Kepler.

Le positionnement de DARWIN dans l’espace était justifié pour pouvoir utiliser des longueurs d’ondes dans l’infra-rouge moyen (« MIR » pour « Mid-InfraRed ») difficilement accessibles ou non accessibles (selon la longueur d’onde) à partir du sol en raison de l’écran atmosphérique terrestre alors que c’est précisément dans ces longueurs d’onde que les exoplanètes réfléchissent le plus de rayonnements électromagnétiques. Le recours à cette gamme de longueurs d’onde facilite ainsi leur observation directe. Il est d’autant plus utile que, dans ce cadre, la différence d’intensité entre le rayonnement d’une étoile et celui de ses planètes est moins importante de plusieurs ordres de grandeurs.

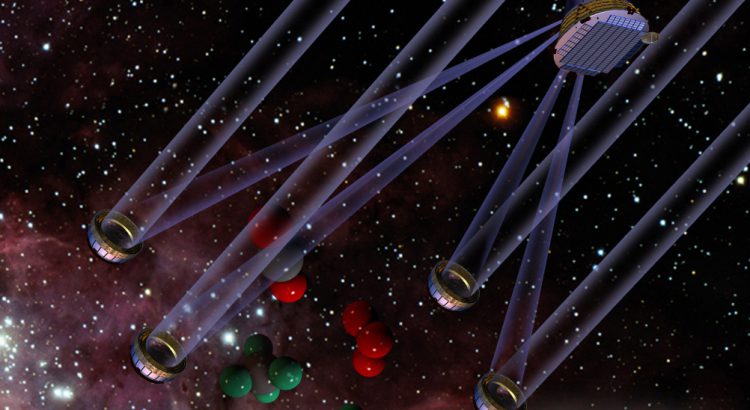

Le choix de l’interférométrie a pour objet de permettre la combinaison des rayonnements reçus d’une même source par plusieurs petits télescopes en formation (dans le cas de DARWIN, minimum trois, maximum neuf, selon les différentes phases de l’évolution du projet), afin de restituer la capacité de discernement spatial qu’aurait un seul grand télescope de dimensions égales aux distances qui séparent les petits télescopes (même si l’intensité lumineuse de l’image qui en résulte est beaucoup plus faible). L’interférométrie a un autre avantage, celui de permettre de dissocier le rayonnement reçu de l’étoile de ceux reçus de ses planètes en annulant (technique du « nulling ») celui de l’étoile et donc de pouvoir observer les planètes, de luminosité beaucoup plus faible que l’étoile.

L’observation directe permet d’obtenir des informations différentes de celles que procurent la méthode des transits ou celle des vitesses radiales; ceci les rend complémentaires. La première (« la directe ») présente, sous certaines conditions, beaucoup d’avantages par rapport aux secondes. Celle du transit est d’autant plus difficile à pratiquer que la planète est éloignée de son étoile (et ne permet de bien identifier que les grosses planètes orbitant très près, et souvent, d’étoiles peu lumineuses, notamment celles qu’on appelle les « Jupiters chauds ») ; celle de la vitesse radiale est d’autant plus difficile à pratiquer que la masse relative de la planète par rapport à l’étoile est faible. Les méthodes de transit et de vitesse radiale s’appliquent donc assez mal (ou « moins bien ») que l’observation directe, à la recherche d’exoplanètes de type terrestre qui sont de petites planètes qui orbitent autour d’étoiles moyennes comme le Soleil (catégorie « G ») et qui passent moins fréquemment (une fois par an ou moins) devant leur étoile si elles se trouvent dans la zone habitable de celle-ci.

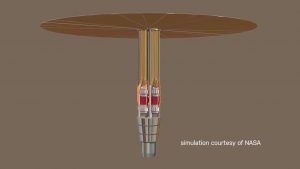

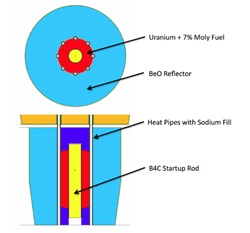

Le projet DARWIN était donc très séduisant. Finalement il fut abandonné pour des raisons techniques et scientifique. La raison technique principale était la difficulté de satisfaire au besoin de précision nécessaire pour le réglage des distances des télescopes entre eux (chacun flottant dans l’espace) et avec le centre commun de collecte des rayonnements (flottant également dans l’espace, au centre de la formation). En effet la tolérance de précision du contrôle est de quelques micromètres pour les distances entre les télescopes et de seulement un nanomètre entre chaque télescope et le collecteur commun des rayonnements (dans lequel se trouve aussi l’interféromètre, des spectromètres et un centre de communication). On avait, de plus, pour occulter la lumière du Soleil, choisi de mettre le système en service au point de Lagrange Terre / Soleil « L2 » qui est en opposition par rapport à notre étoile, mais ce point est un lieu d’équilibre instable qui implique de temps en temps de petits ajustements de position des appareils qui s’y trouvent. Enfin la température des télescopes devait être réduite à 40 Kelvin (pour distinguer les ondes thermiques que sont les MIR), ce qui est une température très basse et donc difficile à maintenir (il faut les alimenter en liquide cryogénique). Sur le plan scientifique, on avait encore, en 2007, identifié peu d’exoplanètes et aucune « petite » planète d’une taille proche de celle de la Terre ; la rentabilité potentielle de l’investissement avait donc été estimée trop basse.

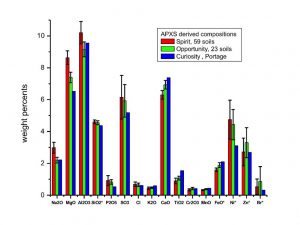

Les résultats abondants de la mission KEPLER de la NASA changent cet environnement et ce raisonnement. On a identifié maintenant plus de 3700 exoplanètes avec certitude et au moins autant de candidates, et KEPLER a permis de constater que la probabilité de planètes de taille terrestre (entre 0,5 et 2 rayons de notre Terre) était élevée. De ces constatations, les chercheurs de l’ETHZ susmentionnés, MM Jens Kammerer et Sascha Quanz** ont pu établir des statistiques (en utilisant la méthode dite de Montecarlo) qui laissent entrevoir la possibilité de quelques 315 planètes d’une taille allant de 0,5 à 6* rayons terrestres orbitant 326 étoiles dans un rayons d’observation de 20 parsecs (65,23* années-lumière). Parmi celles-ci 72 seraient de catégorie G (les plus nombreuses 121, sont des naines rouges, de catégorie « M »).

*NB : il est intéressant de cibler un éventail de tailles de planètes plus ouvert que celui des planètes de taille terrestre, à fin de comparaisons et de compréhension des systèmes stellaires dans lesquels elles peuvent évoluer. La sphère explorée de 65 années-lumière de rayon est très petite par rapport à notre galaxie qui fait 100.000 années-lumière de diamètre mais il faut voir que les planètes étant des miroirs de leur étoile (rayonnements réfléchis) dont le disque est très petit, on ne peut aller beaucoup plus loin.

La recherche pourrait se faire sur 2 à 3 ans et elle utiliserait les longueurs d’ondes MIR de 5,6 / 10 et 15 µm. Les chercheurs estiment que 85 des planètes recherchées pourraient se situer dans la zone habitable de leur étoile. Elles deviendraient alors les cibles d’une seconde phase de l’exploration (sur la même durée que la première) qui serait l’analyse par spectrométrie du rayonnement qu’elles réfléchissent, afin de nous renseigner sur la composition de leur atmosphère.

Les chercheurs sont tout à fait conscients que la recherche d’exoplanètes peut continuer à se faire à partir d’autres instruments, notamment ceux des projets HabEx et LUVOIR de la NASA qui utiliseraient de grands télescopes spatiaux dans les longueurs d’onde allant du proche infrarouge à l’ultraviolet. Ce que j’appellerais « DARWIN revisité », tel qu’ici suggéré, n’est qu’une des options mais une option qui mérite sérieusement d’être reconsidérée car la rentabilité d’un système travaillant dans l’infra-rouge moyen, le plus adapté à la captation du rayonnement réfléchi que nous envoient les exoplanètes et combinant les lumières de plusieurs télescopes, serait la meilleure (c’est-à-dire celle qui nous permettrait d’identifier et de caractériser le plus précisément le plus grand nombre de planètes). Le grand public tout comme la communauté scientifique, doit soutenir ce projet.

Image à la Une : représentation du système de télescopes interférométriques du projet DARWIN de l’ESA. Crédit Université de Liège. Les molécules évoquent l’aspect spectrographie du projet.

**Jens Kammerer et Sascha Quanz sont membres de « PlanetS – Origine, évolution et caractérisation des planètes», l’un des 36 « PRN » (Pôles de Recherche Nationaux) lancés depuis 2001 par le « FNR » (Fonds National de la Recherche Scientifique suisse). PlanetS a été créé par le FNR en Juin 2014. Il est dirigé par le Professeur Willy Benz (Université de Berne). Il réunit des chercheurs des Universités de Berne, Genève et Zurich ainsi que les EPF de Zurich et Lausanne. Il est structuré en « projets de recherche ». Le sous-projet du Dr. Quanz est celui de la « Détection et caractérisation des exoplanètes » à l’intérieur du projet « Disques et Planètes ».

Communication du 27/09/2017 de Mme Barbara Vonarburg, journaliste scientifique, chargée de communication à l’Université de Berne:

http://nccr-planets.ch/fr/blog/2017/09/27/remake-dune-mission-spatiale-annulee/

Etude scientifique: “Simulating the exoplanet yield of a space-based mid-infrared interferometer based on Kepler statistics” par Jens Kammerer et Sascha P. Quanz, in Astronomy & Astrophysics; Oct 19th 2017:

file:///H:/Capsule%20nouvelle%202018%2001%2017/Darwin%20la%20suite/Arwin%20sequel%201707.06820.pdf