Le 27 juin la NASA a annoncé qu’elle allait explorer Titan avec un hélicoptère. La sonde porteuse partira en 2026 et atterrira en 2034. J’aurai alors 90 ans ! Que faire sinon déplorer le temps qui passe, rêver et espérer quand même pouvoir contempler émerveillé ces cieux lointains et apprendre encore ?!

Titan n’est pas un « objet » ordinaire. Nous en connaissons assez bien les caractères généraux grâce à la sonde Cassini de la NASA qui pendant 13 ans a permis d’étudier le système de Saturne, dont il fait partie, avant d’être précipitée dans l’enveloppe gazeuse de cette dernière le 15 septembre 2017.

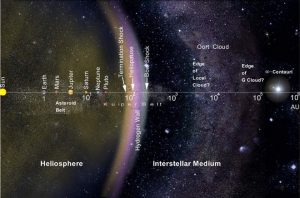

C’est d’abord l’un des deux plus gros satellites des planètes (plus gros que certaines planètes elles-mêmes) du système solaire, 5150 km de diamètre, plus que la Lune (3474 km) ou que Mercure (4875 km) mais moins que Mars (6779 km) et bien sûr que la Terre (12742 km) et légèrement moins que Ganymède (5268 km) le plus gros des satellites de Jupiter. C’est aussi avec la Terre, le seul astre rocheux de notre système, doté d’une atmosphère épaisse (pression au sol 1.47 bars), beaucoup plus que celle de Mars (0,010 bar), mais pas trop (comme celle de Vénus, 93 bars !). C’est encore un astre étrange où les rochers sont en glace d’eau et où dans les fleuves coulent des hydrocarbures qui s’évaporent lentement dans de grands lacs tout au long d’une année de trente ans (29,46), marqué comme la Terre par des saisons puisque l’axe de rotation de Saturne par rapport au plan de l’écliptique est incliné de 26,73° (Terre 23,26°). A noter que c’est cette inclinaison et non celle de Titan sur son orbite qui détermine les saisons puisque la source de chaleur est le Soleil et non Saturne et que l’inclinaison de l’axe de rotation de Titan est seulement de 0,28° sur le plan orbital de Saturne*. Observons le un peu plus en détails :

*cf commentaire du professeur Daniel Pfenniger (UniGe).

Tout d’abord, nous devons prendre en compte la caractéristique structurelle primordiale de tout corps céleste, sa masse. Elle est très faible, 134,5 contre 639 pour Mars, 5972 pour la Terre et 56830 pour Saturne (en milliards de milliards de tonnes – 1,345 à la puissance 23 !) mais quand même le double de celle de la Lune (73,6). Ce rapport entre la taille et la masse de l’astre détermine sa densité et résulte de sa composition particulière, fonction de sa localisation dans le système solaire et dans le sous-système saturnien. Compte tenu de sa formation bien au-delà de la Ligne-de-glace, qui passe au milieu de la Ceinture-d’astéroïdes (entre Mars et Jupiter), il est constitué d’un cœur de silicates hydratés (pas de métal !) enrobé dans de la glace d’eau mêlée d’hydrocarbures mais comme la pression et la chaleur interne jouent, cette glace perpétuellement solide à l’extérieur (sauf éventuel volcanisme) est liquéfiée à l’intérieur au point qu’on pense que grâce à la présence d’ammoniaque (NH40H – qui abaisse le point de congélation), elle a pu constituer un véritable océan planétaire souterrain. Par ailleurs la faible masse a pour conséquence une faible gravité en surface, légèrement inférieure à celle de la Lune (0,135g contre 0,16g). Combinée à la densité de l’atmosphère cela crée la condition idéale pour l’exploration robotique aéroportée (comme nous le verrons plus tard).

Un autre caractère planétologique important est la composition de l’atmosphère. Elle est constituée de 95% à 98,4% d’Azote (Terre 78,09%) et de 5 % à 1,6% d’hydrocarbures dont principalement du méthane (CH4) et un peu moins d’éthane (C2H6); l’hydrogène suit avec 0,1 % et, en plus faibles quantités (« traces »), de toutes sortes de composés: acétylène, propane, mais aussi de CO2 . A la température ambiante, le méthane se trouve aux alentours de son point triple. Il y a donc, en instabilité selon les variations de températures, du méthane gazeux dans l’atmosphère et liquide en surface. Une grande partie du « charme » de titan repose sur le cycle des liquides et des gaz. Il y a, surtout dans la région des pôles, ces lacs de méthane mentionnés plus haut. Ils sont soumis à une forte évaporation qui alimentent l’atmosphère en nuages. Compte tenu de la rotation lente de l’astre sur son axe (15,95 jours) et des faibles changements de températures résultant de l’exposition au Soleil cette atmosphère est en mouvement, parcourue par de faibles vents. Avec l’évolution des nuages, il pleut et il neige sur Titan en grosses gouttes ou en gros flocons qui tombent lentement (gravité et densité de l’atmosphère!) sur un sol déjà enrichi et complexifié au cours des éons ; et des orages se déclenchent, avec de la foudre, donc des éclairs et du tonnerre qui gronde d’autant plus que l’atmosphère dense en transmet bien le bruit. Outre ces décharges électriques, les radiations solaires (Uv) et galactiques (le satellite ne jouit pas de la protection d’une magnétosphère), ajoutent aux facteurs dissociatifs et associatifs des molécules complexes en suspension dans l’air et déjà accumulées au sol.

En dehors des lacs et des pics les plus acérés, le sol est en effet, en raison de ces processus qui durent depuis des milliards d’années, recouvert de matières hétéropolymères, les « tholines », substances visqueuses et collantes, proches de nos goudrons. Elles ressemblent aussi beaucoup aux « résidus récalcitrants » (selon Carl Sagan) obtenus par Miller et Urey au bout de leurs recherches en laboratoire visant à synthétiser les composants de base de la vie par décharges électriques dans une supposée atmosphère terrestre primitive. A noter et c’est important, qu’il s’est avérée plus tard que la composition de cette atmosphère reposait sur des hypothèses inexactes, l’atmosphère primitive terrestre contenant probablement beaucoup moins d’hydrogène, beaucoup plus de gaz carbonique et du souffre.

Un phénomène intrigue, l’intermittence de certains lacs. Cela indique évidemment une faible profondeur, une forte évaporation mais aussi peut-être une porosité du sol et quand on rapproche cette possibilité de la présence d’un océan souterrain, on peut envisager des communications entre la surface et l’Océan et donc encore plus de possibilités « biotiques » car l’environnement océanique pourrait permettre aux polymères organiques formés en surface de contourner l’obstacle du très grand froid pour continuer à évoluer dans des conditions plus favorables.

Enfin, comme la Lune, Titan est un satellite en évolution synchrone avec sa planète. C’est-à-dire que tout en tournant sur elle-même, elle lui présente toujours la même face. En effet Saturne verrouille l’exposition de son satellite par force de marée puisqu’elle n’en est distante que de seulement 10 diamètres saturniens (1,22 millions de km) et que sa masse est beaucoup plus importante que celle de Titan. Ceci veut dire que l’autre face n’est jamais exposée vers Saturne. Cela a-t-il des conséquences sur le climat ou les différents flux dans l’atmosphère, dans le sol, dans la structure interne de la planète ? Cela ajoute-t-il à la richesse des processus d’échanges biochimiques en cours ? Le sujet sera probablement étudié un jour.

Son atmosphère et la présence de liquide en surface conduisent certains à dire que Titan ressemble à une Terre primitive. C’est peut-être extrapoler sur des éléments insuffisamment analogues (la composition de l’atmosphère) et ignorer d’autres aspects très différents (la température). Le système de Saturne est froid, très froid car il se trouve loin du Soleil, entre 1349 et 1505 millions de km (10 Unités Astronomiques, « UA »), soit entre 9 et 11 UA de la Terre (qui se trouve par définition à une UA du Soleil). Compte tenu de l’éloignement du Soleil, l’irradiance au niveau du système saturnien est très faible (14,9 W/m2 soit 1/100ème de celle de la Terre et 1/50ème de celle de Mars). La luminosité en surface est donc très faible, d’autant qu’il y a des nuages, et la température moyenne est très basse (-180°C) et elle varie très peu. Mais il faut reconnaître que c’est un monde complexe et actif, certainement un incubateur qui a dû pousser la complexification des processus chimiques plus loin que la plupart des autres astres du système solaire.

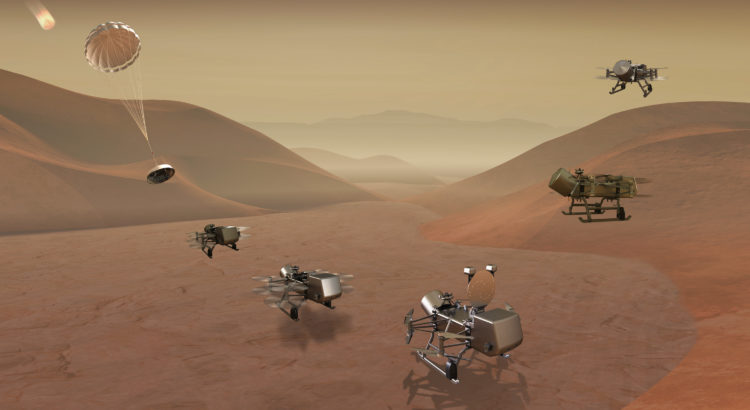

L’exploration de Titan n’est pas facile, à cause de la distance et du temps nécessaire pour l’atteindre et ensuite pour commander les manœuvres des robots (les signaux mettent en moyenne 1h20 dans un seul sens) et à cause de la température, des orages et des étendues liquides (il vaut mieux éviter d’y couler, avant de s’y noyer!). La NASA a choisi la bonne solution puisque l’atmosphère est porteuse : l’hélicoptère, en l’occurrence un quadricoptère ou « quadcopter » comme disent les Américains, dotés de quatre couples de deux rotors (deux couples de chaque côté). L’idée a été lancée en l’an 2000 par le spécialiste de Titan, Ralph Lorenz (« planetary Scientist » au John Hopkins University Applied Physics Laboratory –JHUAPL)…le temps passe et les projets d’exploration mettent toujours longtemps à éclore…quand ils éclosent ! Curieusement le projet est devenu une affaire de famille car si Ralph Lorenz est le Project Scientist (responsable scientifique) de la mission, c’est son épouse Elizabeth Turtle, de la même université, qui en a été nommée la « Principal Investigator » (responsable générale). La mission nommée « Dragonfly » (libellule) sera effectuée dans le cadre du programme « New-Frontier » de la NASA, comme New-Horizons dont la sonde vient de passer à proximité d’Ultima-Thule, le premier objet de la Ceinture de Kuiper observé en détail, Juno qui orbite aujourd’hui autour de Jupiter ou comme Osiris-Rex qui étudie actuellement l’astéroïde Bennu. L’objet de Dragonfly est d’étudier la géologie de surface, la météorologie et leurs interactions (exactement ce qu’on pouvait demander !). Le budget est « raisonnable » (comme doivent l’être ceux des projets « New-Frontier »), un milliard de dollars seulement (hors lancement qui coûtera probablement une centaine de millions de dollars).

Dès le début de la mission le quadcopter mettra à profit la densité de l’atmosphère. Il ne sera pas déposé au sol mais libéré avant l’atterrissage, dans la basse atmosphère (à 1,2 km d’altitude) après une descente freinée par bouclier thermique puis par deux parachutes successifs. Ceci lui permettra la reconnaissance du meilleur site pour se poser et aussi une première observation. Ensuite l’engin rechargera ses batteries pour pouvoir faire un nouveau vol (il passera plus de temps au sol que dans les airs car outre ce rechargement, il fera des observations du sol et enverra les données collectées vers la Terre). En plus des caméras, il y aura à bord des spectromètres, des capteurs météo, un sismomètre . Des forets fixés sous les patins d’atterrissage permettront de prélever des échantillons qui seront analysés sur place. Une innovation intéressante sera l’installation d’un dispositif de réalité augmentée qui permettra de contrôler périodiquement en trois dimensions l’appareil et son environnement immédiat dans d’excellentes conditions, « comme si on y était ».

Le premier atterrissage aura lieu sur l’équateur (il est toujours plus facile de s’y poser car c’est au-dessus de cette zone qu’arrive naturellement un vaisseau spatial attiré par la force de gravité de l’astre et il n’est pas nécessaire de dépenser d’énergie supplémentaire pour monter en latitude), dans la région de Shangri-La (c’est un champ de dunes comme il y en a beaucoup dans cette région). Ensuite Dragonfly fera de petits vols jusqu’à 8 km de distance et 500 mètres d’altitude ; sur les deux ans et demi que durera la mission il devrait parcourir 175 km. Cela le mènera jusqu’au cratère Selk intéressant par la variété de ses roches notamment parce que l’impact qui l’a généré a permis la libération, et l’action en surface, d’eau liquide. Bien entendu l’énergie utilisée sera nucléaire, sans doute un RTG (radioisotope thermoelectric generator) fonctionnant au plutonium 238 (convertissant en électricité la chaleur résultant de la désintégration radioactive du métal) ou peut-être un réacteur de type Kilopower fonctionnant à l’uranium 235, car à cette distance utiliser l’énergie solaire est impensable, l’irradiance étant beaucoup trop basse.

Alors verrai-je les films que Dragonfly prendra de ce monde étrange ? Quoi qu’il en soit de mon destin, vous les plus jeunes ne manquez pas de vous en rassasiez ! Ce seront des photos crépusculaires comme les rives que j’aborderai ou que j’aurai déjà franchies. Vous contemplerez dans une atmosphère ocre-dorée tirant vers l’orange et sombre, la lueur de Saturne réfléchissant la lumière du Soleil lointain. L’image beigée de la planète géante entourée de ses anneaux évoluera comme sur Terre celle de la Lune en fonction de ses phases. Énorme et immobile dans le ciel, elle dominera les montagnes de glace et se reflétera comme dans nos plans d’eau terrestres, dans quelque plan d’éthane liquide, noir et lisse. « Vous » ne serez pas encore dans vos scaphandres chauffés, les pieds dans vos bottes fourrées pataugeant dans la boue de tholines de ce monde glacial mais si nous sommes déjà parvenus sur Mars, nul doute que vos descendants y accéderont un jour avant d’aller encore plus loin. Ce sera splendide!

Image à la Une: Dragonfly en mouvement au-dessus du sol de Titan. Illustration crédit: John Hopkins APL.

Image ci-dessous: Dragonfly au sol. Le cylindre à l’arrière est le RTG. Crédit: John Hopkins APL.

liens:

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: