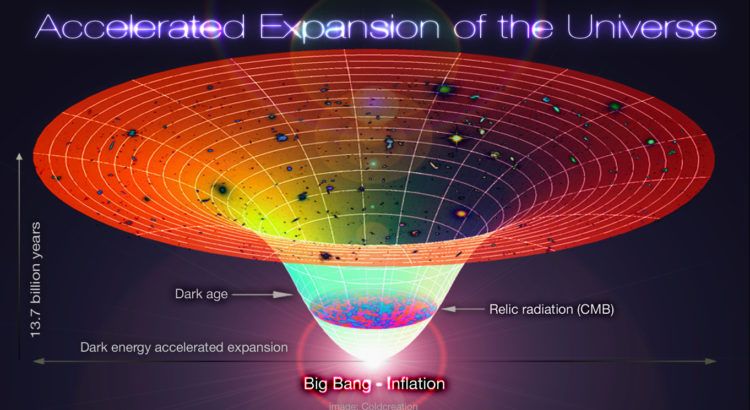

Depuis Alexandre Friedman en 1922/24 on a réalisé que l’Univers non seulement n’était pas statique comme le croyait Albert Einstein mais qu’il est en expansion et, depuis 1988 avec le « Supernova Cosmology Project » dirigé par Saul Perlmutter et l’équipe « High-Z supernovae search » dirigée par Adam Riess, que non seulement il est en expansion mais que cette expansion apparemment s’accélère.

La cause de l’interrogation

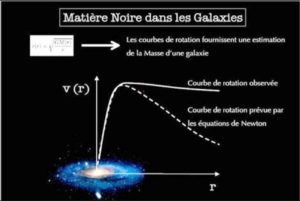

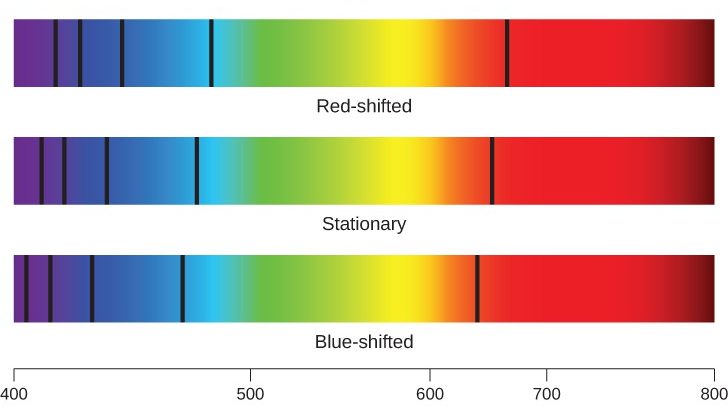

L’expansion de l’Univers est maintenant une réalité qu’aucun astrophysicien ne conteste. On la constate par le décalage vers le rouge (effet Doppler-Fizeau) observé dans le spectre des galaxies de l’Univers observable et qui est d’autant plus important que les galaxies sont lointaines. Le problème est qu’après cette première constatation que l’on a formalisée en lui affectant une grandeur que l’on a crû être une « constante », la « constante de Hubble » (« H »), on s’est aperçu qu’elle n’était que la valeur actuelle (environ 70km/s/Mpc), « H0 », d’un simple paramètre, la possibilité de variation de ce paramètre résultant de la contradiction entre d’une part une force de contraction tenant à la masse de l’Univers subissant l’effet de la gravité, exprimé par le « paramètre de densité » (que l’on symbolise par « Ω » (Oméga), et d’autre part une force répulsive dont on ne peut encore que constater l’effet. La totalité de la matière, noire ou visible, et la force de gravité qu’elle implique, ne suffit donc pas à ralentir l’expansion (bien au contraire) ! Cette force répulsive que faute de mieux on appelle « énergie sombre » car on ne peut en identifier la nature, semble dominer l’Univers depuis 6 à 7 milliards d’années (sur 13,8 milliards). C’est à cette époque qu’elle commence à se traduire par une accélération générale de l’expansion, mais elle était sans aucun doute à l’œuvre dès l’Origine, c’est à dire le Big-bang, ou même, selon certains, peut-être avant ; il est en effet difficilement concevable qu’elle ait pu être créée ex-nihilo ensuite.

La force répulsive est déjà potentiellement présente dans l’équation de champ modifiée d’Albert Einstein (Gαβ = 8πTαβ + Λgαβ), par son coefficient « Λ » (lambda), qu’il avait lui-même appelé la « constante cosmologique » (mais il n’est plus certain aujourd’hui qu’elle soit constante !). Il faut dès à présent noter qu’il avait ajouté ce coefficient (cette « verrue » dira-t-il plus tard) à sa formule de base pour un objet différent de la prise en compte de la possibilité de variation de l’expansion. Il voulait simplement exprimer que pour lui l’Univers était statique (et sa constante cosmologique corrigeait exactement l’effet de la gravité). Les observations ultérieures et notamment celles du télescope spatial Planck ont montré que Λ pouvait avoir une valeur de 1,1056 × 10−52 m−2…avec une marge d’erreur. La valeur est très faible mais très légèrement positive et il faut bien voir que l’échelle est la plus grande qu’on puisse imaginer et donc que l’accélération est réelle, qu’elle représente du fait de l’immensité à laquelle elle s’applique, l’élément le plus important de la « densité de l’énergie totale de l’Univers » (72,8%) et par conséquent qu’elle implique dans le futur lointain la dispersion de la Matière. A noter que le coefficient Λ affectant comme le coefficient Ω le paramètre de Hubble, est repris dans le modèle cosmologique « ΛCDM » (Lambda Cold Dark Matter) considéré aujourd’hui comme le « modèle standard du Big-bang » (qui met à jour le raisonnement d’Einstein). Mais on ne sait toujours pas ce qui peut bien provoquer cette accélération !

Les réponses possibles

Les cosmologistes ont fait beaucoup d’efforts pour trouver une explication à l’accélération. En gros on peut dire que la quasi-totalité (« A ») de leurs propositions recourent à des forces, des champs ou des particules que permettent sur le papier la science physique mais qu’on n’arrive pas à prouver / détecter et qu’une seule proposition (« B »), celle d’André Maeder, utilise la physique telle qu’elle est. Parmi les premières, certaines (1 et 2 ci-dessous) gardent la théorie de la Relativité Générale en y introduisant des « degrés de liberté » (variables aléatoires qui ne peuvent être déterminées ou fixées par une équation), d’autres (3 et 4 ci-dessous) la modifient. Voyons les dans l’ordre de leur éloignement progressif du modèle standard :

1) introduction de nouveaux champs physiques ou de nouvelles particules qui n’interagissent ni avec la matière baryonique, ni avec la matière noire, ni avec les photons. Les modèles de cette catégorie comprennent notamment la « quintessence » (Jim Peebles), une cinquième forme d’énergie active à chaque point de l’espace (à côté de la matière baryonique, de la matière noire, des neutrinos et des photons).

2) introduction de nouveaux champs très faibles qui peuvent être couplés avec les seuls photons et qui expliquent l’atténuation de la lumière par la distance (par une oscillation photons/« axions »…les axions étant des particules théoriques, de type boson, n’ayant pas de charge électrique et une très faible masse).

3) introduction de nouveaux champs, fortement couplés à ceux du modèle standard de la Relativité Générale. Ce couplage fort implique de modifier les équations de la Relativité Générale et/ou de changer les valeurs de certaines constantes fondamentales pour décrire les effets de la gravitation.

4) introduction de modifications drastiques à la théorie de la Relativité Générale avec plusieurs types de « gravitons » (bosons de masse nulle, particules théoriques porteuses de la force de gravité). Les modèles incluent les modèles « branaires » avec dimensions supplémentaires ou la « multigravité ».

Toutes ces hypothèses supposent beaucoup d’inconnues et ne sont pas (encore) testables puisqu’on n’a découvert / observé aucune des particules ou champs dont l’existence supposée est indispensable à leur vérification.

Dans ces conditions la proposition (« B ») d’André Maeder (Université de Genève) exposée en 2017 dite « invariance d’échelle du vide » qui suppose qu’aux grandes échelles cosmologiques, niveau où la théorie de Relativité Générale peut être appliquée, le vide et ses propriétés ne changent pas par suite d’une dilatation ou d’une contraction, présente l’avantage de la simplicité et d’une sorte de « retour aux sources » (les premiers travaux d’Albert Einstein). Selon ce modèle, l’accélération de l’expansion de l’Univers serait possible sans que l’énergie sombre ou la matière noire soient nécessaires et avec une « constante cosmologique » Λ liée uniquement aux propriétés d’invariance du vide spatial, via un facteur d’échelle « λ » de ce vide . Cette hypothèse fait en effet apparaître logiquement, on pourrait dire « naturellement » (c’est le terme employé par André Maeder), un terme très petit et variable d’accélération et ce « terme » est particulièrement significatif aux faibles densités. Or l’accélération est en effet, dans les observations, un terme très petit et c’est dans ces environnements de faibles densités (périphérie des galaxies spirales par exemple) qu’elle semble la plus évidente. Les premiers tests du modèle corroborent les observations : application de ses principes au calcul des distances par rapport aux décalages vers le rouge, à l’estimation de la magnitude par rapport aux redshifts, à l’estimation du coefficient de densité Ω par rapport aux observations par le télescope Planck des fluctuations du CMB (Fonds diffus cosmologique), à l’estimation de la valeur actuelle du paramètre de Hubble (coefficient H0), et autres.

Dans tous les cas il y aurait bien expansion et du moins actuellement, accélération de l’expansion. Ce sont des faits d’observation. Mais il n’y aurait pas obligatoirement d’énergie sombre et s’il y a énergie sombre, ce qui est de moins en moins probable, on ne sait toujours pas ce qu’elle serait. L’accélération de l’expansion de l’Univers reste un problème majeur pour la compréhension de notre Univers puisque d’elle ou de son contraire résultera (dans plusieurs dizaines de milliards d’années, tout de même !) la Destruction (Big Crunch ou Big Rip) ou l’Eternité (par le chemin de crêtes…mais on ne sera jamais certain de pouvoir y rester !). C’est un sujet difficile que je n’aborde, sans l’approfondir, que pour mettre en évidence son incontournable présence !

Illustration de titre: illustration schématique de l’expansion de l’Univers et de son accélération (évasement). Design Alex Mittelmann

Lien (Le Temps, 22 Nov. 2017) :

https://www.letemps.ch/sciences/un-professeur-genevois-remet-question-matiere-noire

lien UniGe:

https://www.unige.ch/communication/communiques/2017/cdp211117/

lien vers l’étude d’André Maeder:

file:///F:/energie%20sombre/Maeder_2017_ApJ_834_194.pdf

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: