Dernier article publié sur letemps.ch. Pour continuer à me suivre, voir les indications à la fin du présent article.

Les amateurs de mon blog seront heureux de savoir que j’ai écrit un livre. Ils le seront moins d’apprendre en même temps que ce livre stagne dans les limbes de l’édition. Son titre est « Franchir sur Mars les Portes de l’Espace », ce qui laisse imaginer facilement les idées qu’il porte et fait avancer (j’en suis convaincu), sans dévoiler leur contenu précis ni leurs articulations. Pour vous donner encore plus d’envie de le lire, je vais vous raconter sa pré-histoire, un peu comme celle de l’Univers avant qu’il parvienne à la Surface de dernière diffusion, et je vais vous révéler quelques indices accrocheurs (je l’espère) sur son contenu.

En décembre 2019, j’ai reçu un mail de la Direction des PPUR (éditeur bien connu en Suisse romande puisqu’il est celui de l’EPFL, Ecole Polytechnique Fédérale de Lausanne). La personne, chargée d’édition, avait pris connaissance de mon blog « exploration spatiale ». Il l’avait apprécié et me proposait d’écrire un livre dans la ligne de cette création continue mais dans un format adapté à fin de publication dans sa prestigieuse maison.

Je suis donc allé à Lausanne pour en discuter. C’est le Directeur des PPUR (devenue ensuite EPFL Press) qui me reçut. Il me confirma de vive voix tout le bien qu’il pensait de ce que j’écrivais et m’assura que sa maison m’aiderait en cas de besoin pour finaliser l’ouvrage.

Sur de telles prémices, je me lançais avec enthousiasme dans l’écriture (de toute façon j’en avais envie depuis quelques temps) et un peu plus tard, en mars 21, je présentais mon texte. La réponse du chargé d’édition qui m’avait été attribué, ne vint qu’en juillet (covid ?) et elle fut décevante. Le livre était trop aride à son goût, il lui fallait du « story telling » pour en faciliter la lecture.

Je n’avais pas envie de diluer la progression de ma « démonstration » dans des considérations personnelles et dans un premier temps, je « laissais tomber ». Puis, réflexion faite, je me résignais à introduire ce que j’appelais des « intermèdes » entre les chapitres pour expliquer mon cheminement vers cette œuvre et ce qui personnellement m’avait inspiré. Le choix de cette formule étant qu’on pouvait se passer de lire les intermèdes si l’on voulait lire l’essentiel (mais aussi que l’on pouvait ne lire que les intermèdes si on ne voulait que me connaître).

En juin 2022, je renvoyais ma nouvelle version dont la substantifique moëlle avait elle-même été modifiée mais malheureusement je tombais sur ce qu’on peut appeler un « aiguillage », mon interlocuteur ayant décidé de quitter EPFL Press. J’évoque cet équipement de chemin de fer car le partant avait quand même transmis mon nouveau projet à ceux qui restaient. Je fus en effet recontacté en Août 2022 par le Directeur éditorial et commercial, qui m’apparut enthousiaste car il m’écrivait : « votre dernière version est de grande qualité, tant sur le fond que sur la forme. J’ai donc le plaisir de vous indiquer que celle-ci est tout à fait susceptible d’intégrer notre catalogue, si le projet est toujours d’actualité de votre côté ». Evidemment qu’il l’était ! Par contre ce « Directeur éditorial et commercial » ajoutait que la touche personnelle que j’avais introduite à la demande de mon premier interlocuteur se révélait inutile (« la version sans intermèdes est de loin celle qui revêt le plus de rythme et de puissance ») ! Le message se terminait par diverses considérations, précises, sur la commercialisation.

EPFL Press me proposa ensuite un contrat en ajoutant, comme une formalité, que mon livre serait soumis à un « expert ». J’étais quand même un peu inquiet car je ne voyais pas à quel type d’expert mon livre interdisciplinaire et novateur pouvait être soumis (l’exploration de Mars supposée, reposant sur l’utilisation du Starship et conduisant à une colonisation).

Cette inquiétude était malheureusement justifiée car le 23 septembre je recevais un mail dont la teneur était la suivante : « Nous venons de nous entretenir avec l’expert mandaté pour l’évaluation de votre travail. Il a souligné la verve et la qualité formelle de l’ensemble, mais nous a également indiqué que votre propos est trop subjectif pour être publié par notre maison. Votre enthousiasme et votre engagement envers la conquête martienne sont indéniables, mais nous ne pouvons engager l’image de l’EPFL au travers d’une vision qui n’est pour l’heure pas officiellement partagée. Nous devons donc pour cette raison renoncer à cette publication. »

Je me demande toujours comment un éditeur peut craindre de publier un livre trop personnel de quelqu’un dont la vision ne pourrait pas être partagée (?!). Rétrospectivement je peux me dire que Chat-GPT a de beaux jours devant elle mais que certains éditeurs doivent trembler.

Je vous ai fait attendre mais je vais vous en dire maintenant un peu plus sur ce « brûlot » qui n’a toujours pas été publié.

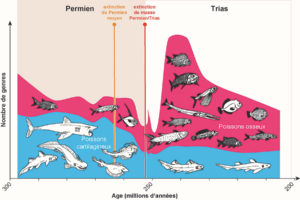

Il s’agit de faire le point de nos connaissances en astronomie, en astronautique, en géologie martienne, en exobiologie et aussi en ingénierie en milieux extrêmes, afin de justifier l’intérêt qu’a l’humanité de s’investir dans la tentative souhaitée aujourd’hui par beaucoup, de s’installer sur Mars.

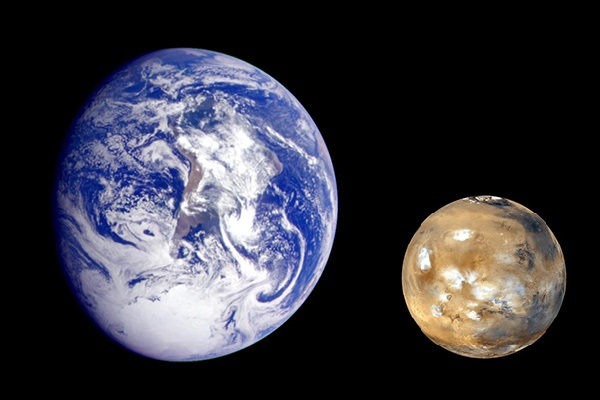

Pour le lecteur, il doit ressortir avec évidence de cette étude que Mars est bien la seule planète accessible qui présente suffisamment de caractères proches de la Terre pour que nos technologies puissent les exploiter à cette fin. Grâce à elles nous pouvons espérer aujourd’hui surmonter les difficultés bien réelles qui s’imposent à nous pour cette installation.

Nous dépendrons pour y aller d’un véhicule. Celui dont la réalisation prochaine est la moins improbable est le vaisseau Starship de SpaceX avec son lanceur SuperHeavy. Le vaisseau lui-même a été testé et il vole. Il faut maintenant que son lanceur SuperHeavy puisse le propulser jusqu’à l’orbite de parking terrestre d’où il pourra s’élancer vers Mars. Il faudra encore disposer d’une énergie suffisante à bord et que la protection thermique du Starship s’avère efficace pour supporter au retour la chaleur de rentrée dans l’atmosphère terrestre. On peut espérer que ces trois conditions soient remplies prochainement.

A partir de là une première mission habitée sera possible, sans doute au début des années 2030. Ce sera le test décisif pour savoir si on peut continuer, c’est-à-dire s’installer durablement sur Mars.

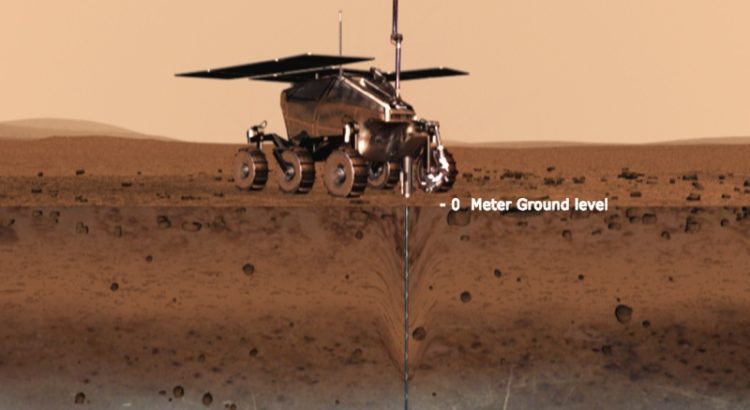

Une fois sur place il faudra utiliser les ressources locales pour respirer, se nourrir, construire, se protéger des radiations et du froid. Il n’est en effet pas question d’envisager transporter toute la masse dont on aura besoin, notre capacité d’emport étant loin d’être illimitée. Par chance, Mars a été formée avec les mêmes éléments que la Terre et il n’y a aucune raison que nous ne puissions les utiliser, en particulier l’eau de ses nombreux dépôts de glace et le carbone/oxygène de son atmosphère de gaz carbonique. Il faudra bien sûr de l’énergie pour utiliser ces ressources et la fission nucléaire avec des réacteurs mobiles importés, semble incontournable même si des panneaux solaires pourront être utilisés en complément.

Les buts ou motivations sont multiples. Il s’agit d’abord d’accroître au plus vite nos connaissances sur une planète dont la proximité peut nous apprendre beaucoup sur la nôtre et les prémices de la vie. En effet un robot accompagné d’un homme sur Mars serait beaucoup plus efficace qu’un robot seul commandé à distance depuis la Terre, avec un décalage de temps de 3 à 22 minutes dans un seul sens. Il s’agit aussi de tester et d’améliorer nos différentes technologies écologiques car l’environnement martien impose une discipline très stricte concernant l’efficacité énergétique et le recyclage, toutes matières organiques ou fabriquées par l’homme étant extrêmement précieuses dans un monde neuf et selon toute vraisemblance, sans vie. Il s’agit encore de répondre à la pulsion d’aventure qui existe, comme à toute époque, dans l’esprit de beaucoup d’entre nous ; l’espace est à ce titre un nouvel Océan qu’il nous faut franchir pour aller voir « de l’autre côté ». Il s’agit enfin de permettre à quelque chose de nous de survivre au cas où, pour une raison ou une autre la Civilisation serait détruite sur cette Terre. Atteindre l’autonomie pour les quelques milliers d’hommes qui pourront partir et s’y établir sera long, c’est pour cela qu’il faut commencer dès que possible. Une fois l’Homme installé sur Mars, il sera de fait devenu une espèce multiplanétaire. Nous aurons bien « franchi sur Mars les portes de l’espace ».

Mes lecteurs du blog Exploration spatiale ne seront pas surpris par cette trame. Mais ce qui compte, c’est la démonstration, la force de la logique et c’est cela que j’ai particulièrement travaillé dans ce livre d’un peu plus de 240 pages, ce qui en fait un ouvrage certes dense mais lisible (et je l’espère, convaincant !).

Mais s’il ne parvient pas à sortir de ses limbes, peut-être ne le lirez-vous jamais. Les livres tant qu’ils ne sont pas publiés sont comme les particules virtuelles présentes en nombres énormes dans le vide mais qui n’apparaissent que rarement dans le monde réel. Ils n’existent que potentiellement même si pourtant ils existent bel et bien car ils ont été, pensés, travaillés, écrits, relus, discutés, tout comme les autres. S’ils parviennent un jour à la face du monde dans les librairies, c’est qu’ils ont plu à un éditeur en fonction de considérations qui peuvent être excellentes mais qui ne le sont pas toujours. En dehors de l’évidence de la qualité et d’une rencontre d’un écrivain avec son éditeur, il peut s’agir de mode, d’un nom connu (auteur ou sujet), d’un scandale ou d’une conformité parfaite à l’ère du temps. Cela ne veut pas dire que tous les éditeurs soient « bien-pensants » ou commerçants avant tout. Je ne veux pas dire non plus que de bons livres ne soient de temps en temps publiés. Simplement il faut de la chance, comme il en faut aussi à tout être inclus dans un œuf fécondé pour naître enfin un jour à ce monde certes magnifique mais aussi insensible et cruel.

A la semaine prochaine sur « mon » blog (voir ci-dessous). Pour moi et je l’espère aussi pour vous, l’« Exploration spatiale » continue !

Illustration de titre : Un vaisseau spatial pénètre dans l’atmosphère de Mars au-dessus de Valles Marineris. Crédit William Black (2015). Imaginez-vous dans ce cadre, pour moi un moment de pure beauté, de rêve et d’espoir !

xxxxx

Attention! Le Temps arrête sa plateforme de blogs aujourd’hui, 30 juin 2023.

Mon blog, “Exploration spatiale”, a dû comme les autres prendre son envol pour migrer ailleurs plutôt que disparaître et cet article est donc le dernier à paraitre sur cette plateforme.

D’ores et déjà vous pouvez me lire sur mon nouveau blog (créé par le développeur Dinamicom) qui reprend toutes les archives (articles et commentaires) du présent blog.

Nom de mon nouveau blog: “Exploration spatiale – le blog de Pierre Brisson“. Lien vers le blog:

https://explorationspatiale-leblog.com

Je serais heureux que vous vous y abonniez. NB: Le Temps n’a pas voulu transmettre à ses blogueurs les adresses mails de leurs abonnés et je n’ai donc aucun moyen de vous écrire.

Pour (re)trouver dans mon blog un autre article sur un sujet qui vous intéresse, cliquez sur (NB: j’ai repris cet index dans mon nouveau blog) :

Index L’appel de Mars 23 06 29

Si vous avez des commentaires à faire sur cet article, merci de les poster sur mon nouveau blog pour permettre aux autres lecteurs et à moi-même d’y répondre au-delà de ce soir.

xxxx

Vous pouvez aussi me lire sur contrepoints.org, porte parole des opinions libérales en langue française (Contrepoints est un media avec lequel j’entretien une relation déjà longue) lorsque sa direction estime mes articles intéressant dans son contexte éditorial.

Vous pourrez encore me lire, de temps en temps, dans les pages du Temps dans la rubrique “Opinions/débats” quand la Direction du journal le jugera utile pour son lectorat général.

A la semaine prochaine, même jour, même heure, sur https://explorationspatiale-leblog.com.

Au revoir letemps.ch et merci au journaliste Emmanuel Gehrig de m’avoir invité à participer à cette belle aventure!