Cette semaine et la suivante je passe la plume à Christophe de Reyff que les lecteurs de ce blog connaissent bien pour ses nombreux commentaires perspicaces et parfaitement documentés, assis sur une qualification professionnelle incontestable*. Il nous emmène à Venise, cité choisie par Galilée pour y tenir son fameux « Dialogue » qui osait défendre, avec une force nouvelle donnée par l’observation avec lunette astronomique, la théorie de Copernic. Non, la Terre n’était pas le centre de l’Univers, comme l’affirmait l’Eglise qui avait fait de l’adhésion aux thèses d’Aristote une question de foi. Il fallait du courage en ces temps d’Inquisition ; ce n’était que quelques années après que Giordano Bruno eut été brûlé vif pour son ouvrage « De l’infinito, universo e Mondi ». Même le Pape qui avait été l’ami de Galilée mais qui estimait sa confiance trahie, ne voulut pas s’opposer à sa condamnation fondée sur ce discours « sulfureux ». Mais le Dialogue avait été publié et il allait faire son œuvre dans les esprits car de plus en plus, l’observation allait démontrer que Galilée, comme Copernic, avaient raison. Aujourd’hui nous vivons à nouveau une époque passionnante de grandes avancées dans la Connaissance. Heureusement l’Eglise ne prétend plus se mêler de tout et la recherche est libre, quoique l’académisme et ses rigidités soient toujours présents dans certains esprits bien diplômés (cf. l’intangibilité de l’hypothèse de la matière ou de l’énergie noire). Mais enfin la parole est libre et la Science peut continuer à avancer, les incertitudes ou le brouillard étant peu à peu éclairés par l’esprit critique des pairs et la multiplication des observations croisées. Grâce à quoi, nous avons fait beaucoup de chemin. Il est donc temps de reprendre ce Dialogue, dans un environnement apaisé, sans jamais oublier ni pardonner le crime commis contre l’esprit il y a 400 ans. C’est à quoi Christophe de Reyff s’est attaché. Pour commencer il va, comme il se doit, dessiner le cadre et rappeler le contexte pour bien nous situer. Maintenant que vous êtes assis, le rideau s’ouvre et je laisse la parole à ses personnages:

Giovan Francesco Sagredo : Messeigneurs, je suis heureux de vous accueillir une nouvelle fois ici à Venise dans mon palais. En ces beaux jours d’automne profitons encore du soleil d’après-midi sur le Canal Grande ! Venise n’est jamais aussi belle en cette saison qu’en fin de journée lorsque les rayons solaires apportent une touche rose aux façades claires et suscitent aussi des reflets cuivrés somptueux dans les eaux de la Laguna.

Simplicio : C’est vrai, Signor Sagredo, vous avez tout à fait raison. Rien ne vaut ce spectacle que je ne me lasserai jamais de contempler.

Filippo Salviati : Je me permets d’ajouter de mon côté que, à première vue, presque rien n’a changé devant nous … Les gondoles sont toujours faites avec exactement deux cent quatre-vingts morceaux de bois, provenant de huit essences diverses, et glissent, toujours sans bruit, sur cette surface plombée et, ce soir, cuivrée, comme vous le dites bien, Signor Sagredo ; ou presque sans bruit, avec seulement, quelquefois, le crissement ligneux du remo dans la fórcola qui transmet l’impulsion donnée par le gondolier à l’embarcation.

Sagredo : Nos souvenirs de ce Dialogue entre nous, de quatre journées, tenu ici-même, ne se sont pas estompés. Si vous le voulez bien, reprenons notre discussion ! Mais il nous faut aller aujourd’hui bien au-delà du point où nous l’avons laissée il y a bientôt 400 ans ! N’oublions pas que notre cher et vénéré Maître Galileo a publié nos entretiens vénitiens dans son ouvrage, devenu vite célèbre : Dialogo … sopra i due massimi sistemi del mondo tolemaico e copernicano …, rédigé entre 1624 et 1630. Il en reçut l’Imprimatur officiel, après bien des péripéties, seulement en 1632. Malgré cela, il a été condamné, précisément le 22 juin 1633, pour cette publication par le tribunal de la Sainte Inquisition à Rome. Lors de cette condamnation, notre académicien a dû abjurer, donc renoncer officiellement à ses idées. Il a été ensuite assigné à résidence pour le reste de ses jours, soit jusqu’à ce triste 8 janvier 1642, où il mourut sereinement dans sa villa retirée, Il Gioiello, sise dans la campagne, près d’Arcetri, non loin de Florence. On sait que, aussitôt, le Grand-Duc de Toscane, Ferdinando II de’ Medici, avait manifesté l’intention d’ériger à sa mémoire, dans la Basilique de Santa Croce à Florence, un « tombeau somptueux, comparable à celui de Michelangelo Buonarroti et lui faisant face ». Mais le Pape Urbain VIII, de son vrai nom Maffeo Barberini, avait fait savoir, par son neveu, le Cardinal Francesco Barberini, sa vive contrariété à l’idée de voir « construire un mausolée destiné au corps de celui qui a été puni par le tribunal de la Sainte Inquisition, et qui est mort au cours de sa pénitence ». On obtempéra… et une simple cérémonie funèbre eut lieu dans l’intimité le 12 janvier, donc sans aucune personnalité. Et ce n’est que presque cent ans plus tard, le 27 mars 1737, sous le règne finissant de l’ultime Grand-Duc, Gian Gastone de’ Medici, que notre cher Maître Galileo put enfin être enseveli dignement, et publiquement. Et tout cela arriva du fait d’un jugement peu éclairé, c’est le moins qu’on puisse dire, au triple motif d’avoir « tenu pour vraie, défendu et enseigné » l’hypothèse héliocentrique du chanoine polonais Nicolas Copernic. On l’a répété à notre cher Maître Galileo : « tu avevi precetto di non tenere, difendere né insegnare in qualsivoglia modo tale dottrina ». Pour toute personne tant soit peu instruite en astronomie, c’est un comble d’entendre cela aujourd’hui ; cette condamnation était due à des juges bien ignorants en la matière, ou simplement bornés, qui refusaient même d’accepter ce qu’ils avaient eu l’occasion de voir dans la lunette astronomique que Galilée avait mise à leur disposition ! Son Dialogo a donc été inscrit à l’Index Librorum Prohibitorum en 1633, ce qui signifie qu’il figurait dès lors dans la liste des livres « les plus pervers et les plus condamnés » ! Il y restera jusqu’en 1757… Au-delà des siècles écoulés, nous avons encore de la peine à y croire. Par cette condamnation, en effet, on signifia à notre cher Maître Galileo qu’il avait désobéi à une ancienne admonition, une interdiction prononcée en 1616 par le Cardinal Roberto Bellarmino, alors à la tête du Saint Office, et décédé du reste dans l’intervalle en 1621. Lors du procès, on exhiba devant notre grand astronome une petite note, écrite curieusement verso-recto – donc sur deux feuillets d’autres documents (ff. 43v et 44r), comme un ajout intercalaire, sur deux autres documents -, devenue un document-clé pourtant, sur lequel ne figurent ni sceau ni la moindre signature ! C’est la fameuse « prescription » (le soi-disant « precetto »), du Cardinal Bellarmino, qui aurait été rédigée le 26 février 1616 ; mais c’était probablement une simple note personnelle faite par le Commissaire général du Saint Office, après l’entretien entre l’astronome et le cardinal, précisant l’injonction signifiée alors de vive voix par ce dernier à l’astronome. Pourtant, notre académicien, lors de son procès, nia, en vain, avoir reçu une telle interdiction ce jour-là.

Simplicio : Ce que vous nous dites là, Signor Sagredo est effrayant. Un astronome ne pouvait donc pas défendre, publier et enseigner une hypothèse qu’il jugeait plus vraisemblable que la conception traditionnelle ?

Sagredo : C’est cela ! J’ajoute maintenant une coïncidence curieuse de l’histoire de l’astronomie : quasiment une année après la mort de notre cher et vénéré Maître Galileo, naissait en Angleterre, le 4 janvier 1643 – pour être précis, c’était à Noël, le 25 décembre 1642 dans le calendrier julien alors encore utilisé en Angleterre jusqu’en septembre 1752 ! -, naissait donc un certain Isaac Newton qui allait bâtir une nouvelle physique, valable sur Terre et dans tout l’Univers, et qui, par-là, allait permettre de décrire correctement et la chute des corps et les mouvements des astres. Il allait aussi concevoir un nouveau type de lunette astronomique, le télescope, avec un miroir concave.

Salviati : Ah bien ! Le flambeau de la science ne s’est donc heureusement pas éteint. De mon côté, pour continuer de parler histoire de l’astronomie, j’ajouterai ceci – et en vous le donnant en mille, comme on dit – : un astrophysicien anglais des plus célèbres, Stephen Hawking, est né le 8 janvier 1942, soit exactement trois cents ans après la mort de notre maître ! On lui doit la conjecture d’un Univers « sans bord », ayant un « commencement » dans un temps imaginaire (au sens mathématique du terme), tout cela afin d’éviter des « singularités » et des grandeurs infinies ; mais c’est un tout autre problème, celui du « commencement » alors que nous allons nous intéresser aujourd’hui à celui de la « fin » de l’Univers !

Sagredo : Depuis ces tristes évènements arrivés à notre cher et vénéré Maître Galileo, bien de l’eau a coulé sous les ponts du Tibre à Rome et sous ceux de l’Arno à Florence et à Pise. Et, au fil des ans, notre Laguna vénitienne a vu son niveau monter et descendre plus de deux cent quatre-vingt-cinq mille fois…

Salviati : Finalement, la révolution, dite « copernicienne » s’est imposée, puis la physique newtonienne, et bien d’autres nouveautés inattendues après elles, donnant dès lors une place très modeste à notre Système solaire parmi les cent milliards d’étoiles de notre Galaxie, ou Voie Lactée, et à celle-ci, parmi des centaines de milliards d’autres galaxies, dans ce que l’on peut nommer l’Univers, ou, plus prudemment, « notre » Univers. Depuis longtemps, heureusement, les astronomes ne sont plus passibles de tels jugements de l’Église, même si les hypothèses qu’ils continuent d’énoncer vont bien au-delà des audaces coperniciennes et galiléennes d’alors ! Je voudrais que nous parlions maintenant justement de l’Univers et plus particulièrement de son destin, laissant pour une prochaine occasion l’autre face du problème, soit son début, joliment nommé Big Bang quasiment dans toutes les langues, au commencement du temps, ou… à peu après.

Sagredo : Serait-ce à dire que les cosmologistes sont encore partagés entre les tenants d’un Univers infini et perpétuel – vous êtes d’accord qu’il ne faut pas utiliser l’adjectif « éternel » qui signifie strictement que le temps n’existe pas, ne s’écoule pas ? -, donc sans commencement ni fin, et ceux qui prônent un Univers fini, avec un vrai début, une vraie fin ou, éventuellement, un début, mais pas de fin brutale du tout ?

Salviati : Oui ! Et il y a aussi ceux qui pensent que le temps existe depuis toujours et pour toujours et que l’Univers a simplement débuté à un moment dans cette durée, comme une fluctuation du vide, et qu’il s’achèvera à un autre moment de ce temps qui s’écoulera toujours ; voire aussi qu’il renaîtrait indéfiniment de ses cendres, de façon cyclique. Parler de fin est-ce vraiment parler de fin apocalyptique, brutale, spectaculaire ?

Simplicio : Si je comprends bien, Signor Salviati, vous allez nous annoncer que nous n’allons pas nécessairement assister dans le ciel à un feu d’artifice sans précédent pour signaler le moment de l’Apocalypse, la fin du Monde ? Mais les observations les plus récentes ne nous disent-elles pas que l’Univers non seulement est en expansion, ce qu’a montré l’Américain Edwin Hubble en 1929, en proposant sa fameuse loi, mais que cette expansion serait même accélérée ?

Sagredo : Mais oui ! Vous êtes très bien informé, Signor Simplicio. Pourtant, je préciserai, de mon côté, qu’on dispose d’une valeur pour la « constante de Hubble » qui semble assez petite aujourd’hui. Du temps des mesures de Hubble, durant les années 1920 et jusqu’à récente date, on a parlé de 500, puis de 150 puis de 100, puis de 75 kilomètres par seconde et par mégaparsec (c’est là l’unité habituelle de cette constante pour les astronomes contemporains). On va donc plutôt vers le bas puisque la valeur actuelle semble être juste en dessous de 70. Qu’en dites-vous, Maître ?

Salviati : Vous avez raison, Signor Sagredo, et vous aussi, Signor Simplicio ! Vos deux énoncés sont exacts. Il existe une loi, dite de Hubble, énoncée en 1929, mais qu’on devrait appeler « loi de Hubble-Lemaître », car le chanoine Georges Lemaître – un autre chanoine après Nicolas Copernic ! – l’avait prévue théoriquement deux ans avant, soit déjà dès 1927, une loi qui donne une relation entre la vitesse et la distance des objets célestes très lointains, les galaxies. Entre les mesures de Hubble dans les années 1920 et aujourd’hui, il s’est passé à peine une petite centaine d’années. Cela n’est pas suffisant pour détecter une éventuelle variation de la « constante de Hubble ». Simplement, les mesures de distances, à l’époque, étaient entachées de grossières erreurs. On a sous-estimé ces distances et la constante était alors trouvée d’autant plus grande. Pourtant, et on en a la preuve expérimentale, il est vrai que, voici des milliards d’années, la « constante de Hubble » était beaucoup plus grande qu’aujourd’hui. C’est pourquoi on ne doit plus parler de la « constante », mais bien du « paramètre de Hubble », car il décroît inéluctablement avec le temps qui passe, avec l’âge de l’Univers, et possède une valeur actuelle, dite « constante de Hubble », qui correspond uniquement à nos observations du moment. Cela semble contredire la très juste affirmation de Simplicio. Car l’Univers est bel et bien actuellement en expansion accélérée. Reprenons la définition du « paramètre de Hubble » : c’est, finalement, le quotient d’une vitesse par une distance. On sait que, actuellement, toutes les deux croissent avec le temps qui passe, mais la distance, qui est une mesure spatiale de l’expansion, et qui est au dénominateur, a toujours crû et continue de croître de plus en plus vite, quasiment aujourd’hui comme le carré du temps qui passe, et, bien sûr, plus vite que la vitesse d’expansion elle-même, qui est au numérateur et qui croît quasiment linéairement avec le temps ; donc le « paramètre de Hubble » diminue, progressivement mais inéluctablement, avec le temps. C’est toujours le cas pour un Univers en expansion. Mais, si l’expansion est aujourd’hui accélérée, cela n’a pas été le cas il y a très longtemps. Car dès le tout début de l’Univers, après une probable et extrêmement rapide phase très puissante, dite d’« inflation » initiale, dont la réalité est encore disputée dans la communauté des astrophysiciens, l’expansion a bien sûr continué sur sa lancée, mais à un rythme freiné, décéléré par la gravitation : le numérateur était décroissant et le numérateur toujours croissant. Bien que l’expansion se fît toujours (le dénominateur allait et continue d’aller toujours croissant), sa vitesse est allée diminuant, elle est ensuite passée par un minimum il y a quelque 6 milliards d’années, puis elle a augmenté à nouveau. Et on en est là actuellement ; la vitesse d’expansion continue d’augmenter. Je vous rappelle que qui dit vitesse décroissante, dit décélération, qui dit vitesse croissante dit accélération. On doit donc admettre que l’Univers a eu une phase d’expansion décélérée, est ensuite passé par un état d’« hésitation », comme l’a joliment écrit le chanoine Georges Lemaître, puis a repris une accélération qui se poursuit actuellement.

Simplicio : Vous me rassurez, Maître. Donc nous allons bien avoir un de ces jours notre feu d’artifice ?

(à suivre)

Illustration de titre : Galilée devant le Saint Office lors de son procès en 1633, huile de Joseph-Nicolas Robert-Fleury (Musée du Louvre)

* Christophe de Reyff, Dr ès sciences, retraité de l’OFEN (Office Fédéral suisse de l’Energie), y a été l’un des responsables de la recherche, pendant plus de 20 ans.

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur :

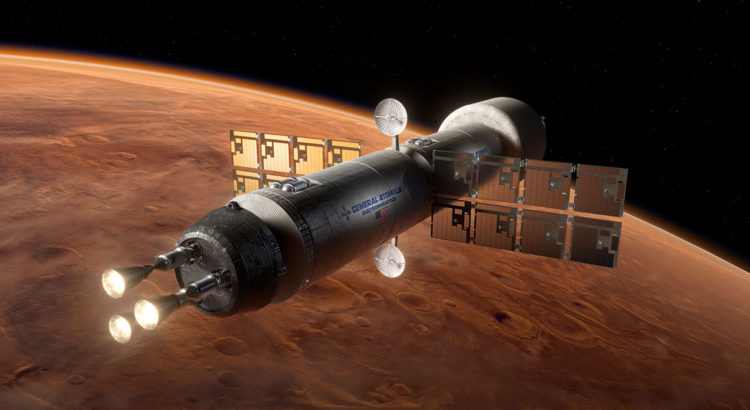

Index L’appel de Mars 23 03 17

NB: L’assemblée Générale des membres de la Mars Society Switzerland aura lieu le 22 mars à 16h00 dans les locaux de Microcity (EPFL, Neuchâtel). Les personnes intéressées à participer peuvent écrire sur le site de l’association (page “contactez-nous”). Ils seront accueillis avec plaisir, sur preuve de paiement de leur cotisation pour adhésion.

Lien vers la page adhésion du site de l’association : https://planete-mars-suisse.space/fr/adhesion