Au cours des dernières décennies, les astronomes ont réussi non seulement à capter l’ensemble du spectre des rayonnements électromagnétiques (EM), mais aussi, en parallèle, à commencer à capter d’autres « messagers spatiaux » : les ondes gravitationnelles (GW), les neutrinos à haute énergie (HEN), les rayons cosmiques et notamment les particules à très haute énergie (« UHECR »). Il s’agit maintenant de corréler les observations provenant de ces différents vecteurs pour obtenir une meilleure compréhension de leurs sources. C’est l’objet de l’« astronomie-multimessager ».

Une université, Pennsylvania State (« Penn State »), a pris l’initiative d’organiser cette concertation sur les signaux à haute énergie, a priori furtifs, quels que soient leurs messagers, en lançant le programme dénommé « AMON » (« Astrophysical Multimessenger Observatory Network »), en faisant un clin d’œil au dieu suprême égyptien qui était par essence un dieu omniprésent mais caché. Déjà de nombreux acteurs ont répondu positivement, dont plusieurs dont j’ai déjà parlé dans ce blog : ANTARES, FERMI, IceCube, LIGO, Pierre-Auger. Nous allons donc pouvoir profiter de ce nouvel espace multidimensionnel qui ne nous est rendu accessible que parce qu’en plus des progrès technologiques dans les différentes techniques d’observation, la science d’exploitation des données informatiques et celle des communications ont également progressé suffisamment. Il faut évidemment saisir et développer ce nouvel outil afin de connaître toujours mieux notre environnement spatial.

NB : AMON n’est pas la première entreprise de coordination mondiale des observations. Cette coordination existe à de multiples niveaux, notamment celui de l’interférométrie des observations radio (« EHT » pour « Event Horizon Telescope ») ou celui des observatoires d’ondes gravitationnelles (« LSC » pour « LIGO Scientific Collaboration ») ou encore, à un niveau purement technique, celui de l’« IVOA » (« International Virtual Observatory Alliance ») mais AMON est la première organisation qui s’efforce de réunir sur une même cible l’ensemble des moyens d’observations quelle que soit la nature de l’émission captée (incluant les ondes gravitationnelles et les neutrinos à haute énergie). Cette coordination se justifie d’autant plus que les émissions visées par AMON résultent d’événements qui peuvent avoir une durée d’expression perceptible sur Terre très courte et que la rapidité de réaction des observatoires est très importante pour en saisir au maximum les composants (nature, intensité et succession) avant qu’ils ne disparaissent.

Selon son site internet, AMON se fixe trois tâches :

(1) permettre aux observatoires participants de partager leurs données les uns avec les autres dans l’anonymat et la confidentialité les plus stricts et conformément à leurs procédures d’analyse à l’aveugle (la confidentialité et la propriété intellectuelle ne sont pas de vains mots chez les chercheurs !) ;

(2) améliorer la sensibilité combinée des observatoires participants, aux phénomènes astrophysiques passagers en leur permettant de rechercher les coïncidences dans leurs données marginales archivées, puis dans leurs données marginales en temps réel ;

(3) Permettre une imagerie de suivi de sources astrophysiques possibles avec une latence minima.

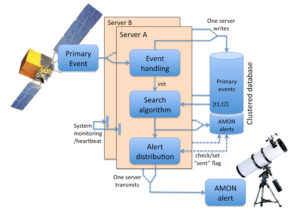

Les participants AMON sont classés en « déclencheurs », en « suiveurs » ou les deux. Les participants-déclencheurs sont généralement des observatoires disposant de télescopes/collecteurs à grand champ (qui couvrent une grande partie du ciel). Ils introduisent leur flux d’événements furtifs dans le système AMON. Ces événements sont traités pour rechercher des corrélations spatiales et temporelles menant à des « alertes AMON ». Les participants-suiveurs recherchent des contreparties électromagnétiques à ces alertes avec des télescopes/collecteurs à champ de « vision » plus étroits mais à haut débit.

Le cœur du système est le « Research Computing and Cyberinfrastructure group » (« RCC ») qui fait partie des « Information Technology Services » de Penn State. C’est ce « group » qui a lancé la coordination et qui la gère dans le cadre d’un « Memorundum of Understanding », « MoU » (daté dans sa version actuelle du 13 Novembre 2017). La coordination a été organisée selon une montée en puissance, comme un moteur qu’on rode. Il s’agissait d’abord de tester les algorithmes d’analyse à partir de données déjà recueillies ; ensuite de fonctionner en temps réel à l’intérieur du réseau des signataires et, à partir de l’été 2016, d’élargir les alertes au public via le réseau des alertes « GCN » (« Gamma-ray bursts Coordinate Network »), avec des règlements et des « garde-fous » permettant la coordination et le contrôle. Chaque alerte porte un numéro d’identification, les coordonnées de temps de l’observation, la direction, le lieu d’incidence (ou les caractéristiques permettant de le localiser), le nombre d’observatoires déclencheurs (les non-détections par certains qui auraient dû percevoir le signal dans le spectre qu’ils couvrent, sont également prises en compte) et une estimation de l’importance de l’évènement. Les communications utilisent un langage standard, VOEvent (adopté en 2006 par IVOA) conçu pour produire des messages compacts et facilement transmissibles.

Comme on parle ici de l’identification événements et non de processus continus et durables (du moins au niveau de notre perception), la vigilance ou ses corollaires la coordination et le recoupement aussi rapides que possible, sont indispensables. Il faut bien voir que cette démarche n’est possible que grâce aux observatoires capables d’utiliser des « messagers » différents mais que le recoupement avec les informations recueillies par les observatoires recevant les signaux électromagnétiques, aujourd’hui très nombreux, sont très importants de ce fait. La validité de cette démarche repose également sur les systèmes de communication modernes ultra rapides et capables de transporter quasi instantanément des données complexes mais claires, tout autour du monde. En ce sens l’astronomie multimessager est un enfant du siècle. Il était naturel de le concevoir mais comme dans toute conception, il a fallu une volonté pour la déclencher. Remercions donc Penn State de son initiative.

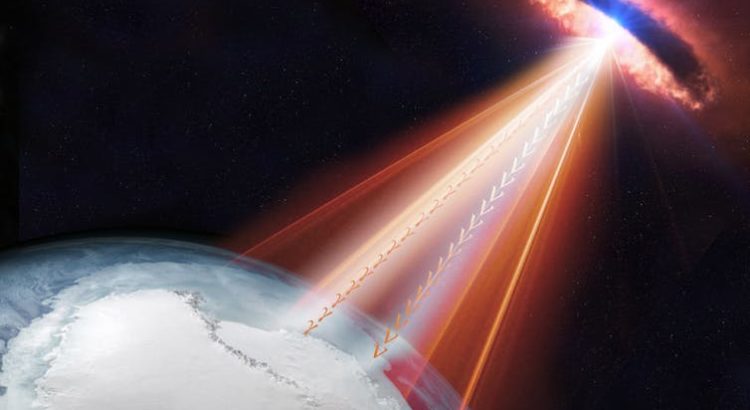

La première observation concluante utilisant AMON a eu lieu le 22 Septembre 2017. A cette date l’observatoire IceCube a collecté un neutrino dont l’identification telle qu’il l’avait « vue » dans ce rayonnement, fut immédiatement diffusée dans le réseau (IceCube s’était branché sur le réseau AMON en Avril 2016). Dans ce cadre les informations parvinrent en quelques secondes aux autres observateurs potentiels. La source logique selon les indications d’IceCube, un blazar situé à 3,7 milliards d’années-lumière (« TXS 0506+056 »), fut très rapidement constatée par le télescope spatial Swift de la NASA (dédié à l’observation des sursauts gamma), puis par le télescope spatial Fermi (en rayons X) et au sol par MAGIC (Major Atmospheric Gamma Imaging Cherenkov Telescope, en rayons gamma). Il fut repéré ensuite par des télescopes opérant dans d’autres zones du spectre électromagnétique. Au-delà de l’identité, on avait ainsi la preuve que les blazars pouvaient émettre des neutrinos en même temps que des rayons gamma et on avait pu observer la succession des émissions avec leur importance relative d’où on a pu déduire la puissance de l’événement, le redshift en visuel de l’objet (décalage vers le rouge dû à l’effet Doppler-Fizeau) donnant par ailleurs la distance à notre système. L’expérience a donc été satisfaisante et très encourageante.

Image à la Une : Dans cette vue d’artiste, un blazar (qui pourrait être TXS 0506+056 !) émet des rayonnements dont des neutrinos (ν) et des rayons gamma (γ) , qui peuvent être détectés par IceCube comme par d’autres télescopes sur Terre et dans l’espace. Les blazars sont des cœurs actifs de galaxies avec un jet de matière et de rayonnements pointant perpendiculairement à leur plan orbital. Crédit IceCube/NASA.

https://fr.wikipedia.org/wiki/Astronomie_multimessager

Pour (re)trouver dans ce blog un article sur un sujet qui vous intéresse, cliquez sur:

Index L’appel de Mars 22 12 18

Meilleurs vœux pour l’année 2019 !