Ce 12 juillet, la NASA avait organisé une présentation, à Greenbelt, Maryland, au siège de la STC (voir plus bas), de cinq des premières images prises par le nouveau télescope spatial James Webb, « JWST ». Le jour est historique comme le fut celui où furent présentées les photos du télescope Hubble après qu’on ait eu corrigé sa myopie initiale (1990). La différence entre la « production » des deux télescopes est spectaculaire. On ne peut pas dire seulement qu’on voit plus loin. On devrait dire qu’on voit plus loin car on voit mieux, ce qui sous-entend (1) que les astres et formations stellaires proches sont perçus beaucoup plus nets et précis et (2) que l’on voit effectivement beaucoup plus loin.

La différence est due à la taille des miroirs mais aussi au fait que les télescopent exploitent des longueurs d’ondes différentes, les deux étant liés.

D’abord le diamètre du miroir primaire du JWST est de 6,5 mètres contre 2,4 mètres pour celui de Hubble. Ensuite le traitement des rayonnements reçus n’est plus centré sur les ondes visibles (avec franges dans l’ultraviolet et dans l’infrarouge) comme l’est celui de Hubble, mais sur les ondes infrarouges, jusqu’à 29 microns (contre 1,7 microns pour Hubble) avec toujours une frange dans le visible. Cela permet de voir les sources de rayonnements plus froids que celles émettant dans le spectre visible et aussi de les percevoir au-travers des nuages de poussière qui les brouillent ou les cachent en visible.

La dimension plus grande du miroir de Webb, outre qu’elle permet de recevoir davantage de rayonnements, est en partie justifiée par la longueur des ondes que l’on veut capter. En effet les ondes infrarouges étant plus longues que les ondes visibles, on a besoin d’une surface plus grande pour que l’image qu’elles nous communiquent soit suffisamment fine. Dit autrement, la surface de collecte renforce l’acuité du télescope donc son pouvoir de résolution qui autrement aurait été plus faible. Ce dernier sera comme celui de Hubble, de 0,1 seconde d’arc, mais pour des ondes beaucoup plus longues (donc des lumières beaucoup plus faibles).

Les cinq images choisies par la NASA pour sa présentation illustrent les domaines différents dans lesquels JWST sera actif. NB : toutes ces images ont les mêmes crédits photos, NASA, ESA, ASC – Agence Spatiale Canadienne, et STScI – la Space Telescope Science Institute, Institution fondée par la NASA qui gère et dirige, avec participation de l’ESA, la recherche effectuée par Hubble et maintenant par Webb.

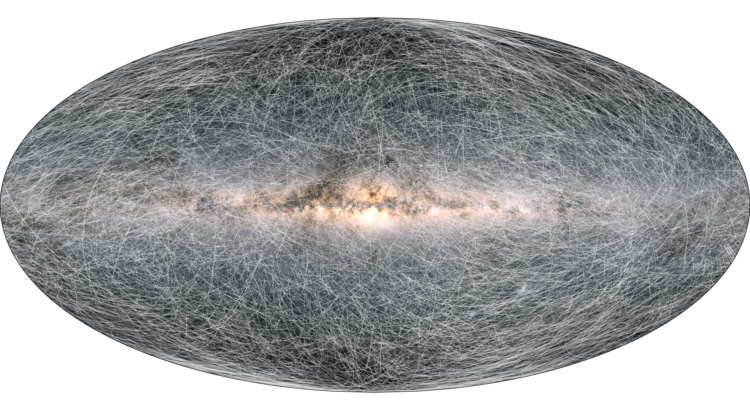

La première photo est celle du « Premier champ profond de Webb »

(cf illustration de titre pour comparaison avec ce que voit Hubble)

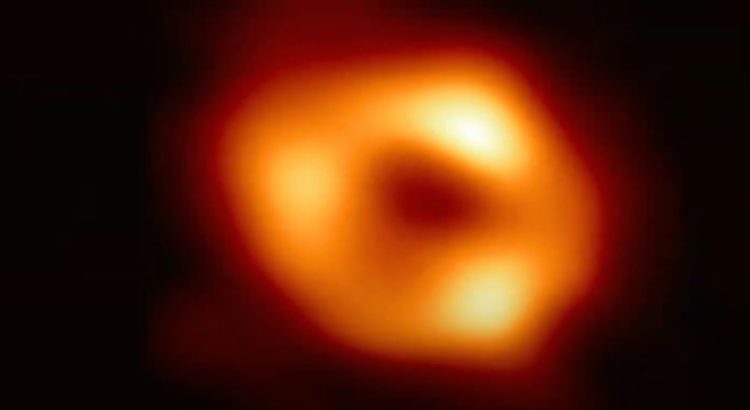

Cette photo est centrée sur l’amas de galaxies « SMACS 0723 » et nous permet d’accéder à des lumières provenant d’au-delà de 13,5 milliards d’années (pour mémoire l’Univers est âgé de 13,8 milliards d’années). On serait, à cette distance, à l’époque des toutes premières galaxies, celles qui ont commencé à luire à la sortie des « Ages-sombres » (il a fallu que la matière se reconcentre après la libération de la lumière, 380.000 ans après le Big-bang). On ne les voit pas en direct mais grâce à l’effet de lentille gravitationnelle (en l’occurrence l’amas de galaxies, au centre de la photo, SMACS 0723) qui nous rapproche comme une loupe le ferait, de ce qui est derrière lui et qui de ce fait, apparaît autour de lui. Les galaxies les plus rouges sont les plus lointaines puisque ce sont celles pour lesquelles l’expansion de l’Univers génère la vitesse d’éloignement la plus élevée (effet Doppler). Sur la voûte céleste l’image aurait la taille d’un grain de sable. NB : les étoiles rayonnantes sont au premier plan, dans notre voisinage galactique.

La deuxième photo montre le « Quintette de Stéphane », cinq galaxies apparemment rassemblées

C’est la plus grande image de Webb en rapport à la surface de voûte céleste (1/5ème du diamètre de la Lune). Les deux galaxies en haut à droite sont en contact ce qui provoque d’énormes ondes de choc en leur sein, bien visibles ici dans la distorsion de leurs courbes, l’une d’entre elles (celle du dessous) est déjà le résultat d’une fusion puisqu’on en voit encore les deux noyaux ; un trou noir puissant se trouve au centre de la galaxie en haut. La troisième galaxie, à gauche, est plus proche de nous.

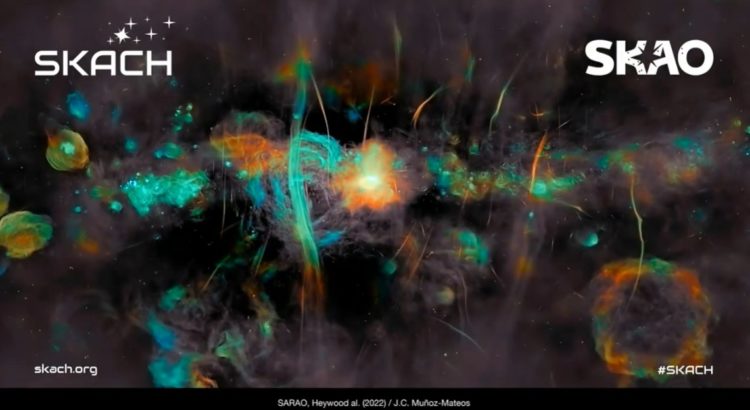

La troisième photo est une vue de la « Nébuleuse de la Carène » (NGC 3324)

La photo met bien en évidence le processus de formation d’étoiles dans cette nébuleuse située à quelques à quelques 7600 années-lumière. Au centre (au-dessus, en dehors de la photo), une étoile extrêmement massive a explosé et a repoussé la poussière galactique et stellaire qui l’entourait. On voit bien (en bleu) le gaz ultra-chaud résultant de l’explosion (en haut) et (en ocre) le nuage de poussière qui l’entoure (en bas). La pression du gaz sur la poussière génère par gravité des concentrations de matière d’où naissent des étoiles, que l’on voit ici à tous les stades de leur formation.

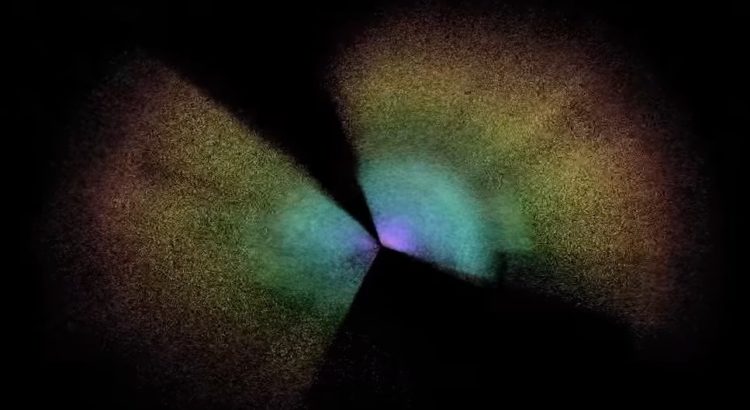

La quatrième photo montre la « Nébuleuse de l’anneau austral » (NGC 3132)

Cette nébuleuse est située à 2300 années-lumière. Le principe est le même que pour l’image précédente mais les étoiles sont différentes en masse et le processus d’évolution est moins avancé. On a ici deux photos prises avec deux caméras différentes à bord du Webb, la caméra en infrarouge proche (NIRCam) à gauche et la caméra en infrarouge moyen qui capte des longueurs d’ondes plus longues (MIRI), à droite. La seconde photo montre pour la première fois que l’étoile au centre est en fait double. La seconde est entourée de poussière, l’autre ne l’est pas ce qui implique que c’est la première qui est la cause de la nébuleuse, pas l’étoile de droite…qui malgré tout connaîtra un jour le sort de sa compagne.

La cinquième photo est le spectrogramme d’une planète massive proche de son étoile répertoriée « WASP-96 »

C’est l’une des quelques 5000 exoplanètes identifiées à ce jour. C’est un « Jupiter-chaud » c’est-à-dire une très grosse planète (la moitié de la masse de Jupiter) et d’autant plus volumineuse qu’elle est très peu dense (diamètre 1,2 fois celui de Jupiter). Distante de seulement 1/9ème de la distance de Mercure au Soleil, elle fait le tour de son étoile en 3,5 jours ; comme l’étoile est de type solaire, la planète est, de ce fait, très chaude. On ne peut toujours pas « voir » une telle planète puisqu’elle n’émet pas de rayonnement visible et qu’elle est trop petite pour nos instruments (elle se trouve à 1500 années-lumière de nous) mais on peut saisir son spectre et son volume, par différence avec celui de l’étoile lorsqu’elle passe entre nous et elle (et évaluer sa masse, par le balancement qu’elle cause à cette étoile). La particularité de ce spectre est qu’il est beaucoup plus précis que jamais et montre la présence d’eau (qui ne peut être que sous forme de vapeur du fait de la température) par absorption de la ligne de l’eau. Cette possibilité de précision nous permettra de rechercher l’eau dans l’atmosphère d’autres planètes moins hostiles à la vie (ou plus terrestres).

***

Il a fallu 25 ans de travail extrêmement difficile pour obtenir ces premières photos, c’est-à-dire 25 ans pour concevoir, réaliser, faire entrer en le pliant comme un origami, l’énorme observatoire Webb sous la coiffe de sa fusée (Ariane V de l’ESA). Il a fallu aussi beaucoup d’argent (plus de 10 milliards alors qu’on avait devisé le projet à seulement 2 milliards en 2001 !). Mais c’est un exploit (dont le lancement réussi par Arianespace n’est pas le moindre élément) et cet exploit ouvre une nouvelle ère pour l’astronomie qui va bien durer aussi 25 ans (pour comparaison, Hubble doit fonctionner jusqu’un peu après 2030).

Lors de l’événement d’hier, tous les participants étaient heureux et soulagés que tout ait si bien fonctionné. Le leader est bien sûr la NASA qui a fourni l’essentiel des équipements mais l’ESA et l’ASC (Agence Spatiale Canadienne) sont aussi participants avec des contributions non négligeables. Autour d’eux de multiples organismes et sociétés, en tout quelques 20.000 personnes au travers du monde !

L’ESA a fourni deux instruments : 1) le spectrographe « NIRSpec », déjà mentionné, fabriqué par Astrium GmbH en Allemagne ; 2) le spectrographe « MIRI », déjà mentionné qui collecte les ondes les plus froides, allant de 5 à 29 microns. Pour réaliser cet instrument 10 pays membres de l’ESA se sont réunis dont la Grande Bretagne, la France et la Suisse. Par ailleurs, comme déjà mentionné, 3) c’est l’ESA qui a effectué le lancement, le 25 décembre dernier, qui a conduit le télescope à orbiter, comme prévu, le point de Lagrange Soleil-Terre L2, à 1,5 millions de km de la Terre, dans la direction opposée au Soleil.

Le Canada de son côté, a fourni un autre spectrographe, « NIrISS », et l’instrument « FGS » (« Fine Guidance Sensor »). Le spectrographe opérera dans les longueurs d’onde allant de 0,8 à 5 microns. Son objet est la détection des exoplanètes et leur caractérisation ainsi que la spectroscopie par transit (analyse de l’atmosphère lors du passage de la planète devant son étoile). FGS est un pointeur pour cibler l’objectif avec la plus grande précision (de l’ordre du millionième de degré). Il a pour cela été qualifié de « volant du Webb ».

Il ne faut cependant pas croire que les Etats-Unis n’ont rien fait. Ce sont eux qui ont conçu et réalisé le télescope proprement dit et son pliage. Par ailleurs ils ont fourni l’instrument « NIRCam », un imageur qui opère dans les longueurs d’onde 0,6 à 5 microns. NIRCam comme FGS sont des auxiliaires à l’observation scientifique effectuée principalement par les deux autres spectrographes.

Pour une fois au moins, tout s’est bien passé et les perspectives sont magnifiques ! « Go Webb, go » comme disent les Américains !

Illustration de titre : Comparaison du même champ profond, vu par Hubble à gauche et vu par Webb, à droite.

Lien : https://www.nasa.gov/webbfirstimages

NB : cet article a été publié le 12/07/2022 dans le journal libéral de référence en France, Contrepoints dont je suis un des contributeurs réguliers.

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: