Les extrémistes climatiques mènent actuellement une campagne contre le tourisme spatial. Ils sont parvenus à mettre dans leur camp Philippe Droneau, le « Directeur des publics » de la Cité de l’Espace de Toulouse. Cette campagne est une menace pour la Liberté et le Progrès. Le raisonnement qui la sous-tend est biaisé et donc infondé. C’est grave, d’autant que Philippe Droneau suggère également d’interdire l’accès de l’espace profond au « vulgum pecus ».

Dans son interview par le magazine en ligne Usbek et Rica publié le 23 juin, il fait essentiellement les objections suivantes : (1) Il y a urgence climatique ; développer massivement des vols suborbitaux de loisir n’est pas pertinent en raison de leur coût écologique (libération de dizaines de tonnes de carbone dans la haute atmosphère) et de leur coût éthique ; (2) Il est faux de prétendre que le tourisme pourrait financer les projets privés d’exploration ou autre ; (3) Mars ne pourra être une « planète B ». Même s’il y a un jour une colonie sur Mars, dans 200 ans, ça concernera une centaine d’individus au plus. La priorité, c’est de s’occuper des bientôt 9 milliards de Terriens et de gérer le vaisseau spatial Terre.

Ma première réponse à ces objections est qu’elles sont sans nuance et donc excessives, comme le sont souvent les déclarations des écologistes politiques. Si « beaucoup » de « quoi-que-ce-soit » (la production d’acier par exemple) peut poser un problème environnemental, « un peu » est souvent non seulement acceptable mais souhaitable. Ce sont les quantités ou les doses qui posent problème et non la nature même des activités humaines. En ce qui concerne les vols de fusées affectées au tourisme spatial ou au transport planétaire terrestre il faut bien voir que la population concernée sera peu nombreuse. On parle de prix qui seront ceux d’une super première-classe s’il s’agit d’aller de New-York ou de Londres à Sydney ou de passer un week-end dans l’espace. On peut envisager l’équivalent de 20.000 CHF d’aujourd’hui par personne. Cela veut dire que très peu de monde répondra à l’offre (pour donner une idée, les passagers de première classe sur long courrier représente 0,3% seulement du nombre de passagers d’Air France). Cela veut dire qu’il y aura relativement peu de vols (peut-être un millier par an). Mais cependant ce nombre de vols sera suffisant pour créer une très sérieuse économie d’échelle permettant d’abaisser considérablement le coût unitaire des éléments réutilisables des lanceurs (dont le premier étage) pouvant être affectées aux Starships interplanétaires qui ne partiront sur la Lune que peut être tous les mois en moyenne et pour Mars que tous les 26 mois (compte tenu de la configuration planétaire). Les vols à objectif scientifique vers la Lune et vers Mars (ou autres) en profiteront forcément ; « it’s the economy, stupid ! ».

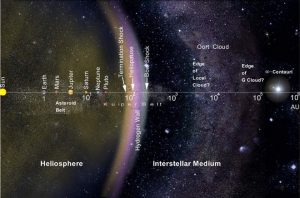

En ce qui concerne l’impact écologique il faut bien voir qu’un excellent cocktail d’ergols est constitué par de l’hydrogène liquide (LH) brûlant dans de l’oxygène liquide (LOX). C’est ce qui était utilisé pour Ariane V et ce n’est pas polluant (production d’eau !). Toutes les combustions ne sont pas polluantes ! On peut certes supposer que pour les voyages martiens on utilisera plutôt le méthane (CH4) brûlant dans le LOX (puisque la production de méthane pour le vol de retour sera relativement facile sur Mars). Cela produira du CO2 ce qui est aujourd’hui considéré comme inacceptable mais il faut bien voir que les vols vers Mars ne seront pas nombreux et que ces vols ne seront pas la seule source de CO2 dans le monde (cf. les centrales à charbon allemandes). Cette limitation résulte d’abord de ce que les possibilités en sont réduites par les fenêtres de lancement (un mois tous les 26 mois) et aussi de ce que pendant très longtemps les infrastructures martiennes seront trop peu développées pour accueillir des dizaines de vaisseaux partis pendant que ces fenêtres sont ouvertes. Quand les infrastructures seront suffisamment développées les technologies de transport auront évolué. Pour les voyages planétaires (point à point du globe terrestre) on pourra continuer à utiliser la propulsion HL/LOX.

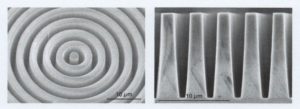

Un autre point à noter est qu’une fusée consomme l’essentiel de ses ergols en altitude relativement basse (contrairement à ce que laisse croire Philippe Droneau). En effet ce qui représente la masse la plus importante d’un vaisseau spatial avant décollage c’est la part des ergols qui va permettre le décollage de la totalité de la masse*, incluant la totalité de ces mêmes ergols, avec une force suffisante pour lui donner une vitesse initiale qui permettra ensuite une accélération toujours plus rapide, tant qu’il y aura du carburant. Plus le vaisseau monte, plus il prend de la vitesse et plus sa masse se réduit. L’essentiel est donc consommé dans les premières dizaines de km d’altitude (grâce à la plus grande partie de la masse du premier étage) et non pas dans la « haute atmosphère » (comparez juste visuellement le volume d’un premier étage avec celui d’un second étage, sans y inclure l’habitat ou la charge utile).

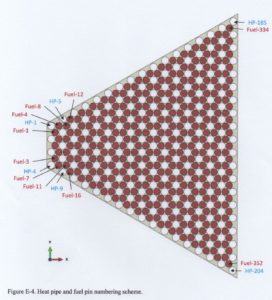

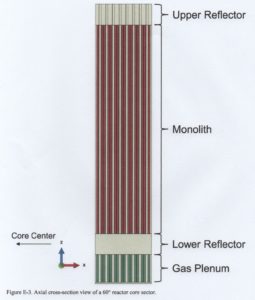

*Pour le “Super-Heavy”+”Starship” de SpaceX (le tout étant appelé précédemment le “BFR”), 4400 tonnes dont 3065 pour le premier étage (Super Heavy) et 1335 pour le second étage (Starship) dont 185 tonnes à vide (ou plutôt “à sec”) avec sa charge utile (100 tonnes). Pour comparaison l’Airbus a380 a une masse de 575 tonnes au décollage et une masse de 277 tonnes à vide.

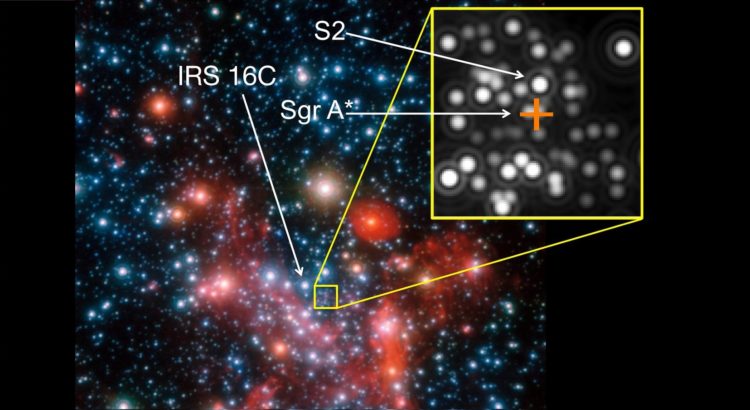

Ma deuxième réponse est qu’en niant l’intérêt des vols touristiques, Philippe Droneau ne voit pas que non seulement ils vont permettre de réduire le prix unitaire des vols scientifiques effectués avec les mêmes fusées (comme développé plus haut) mais aussi que sur Mars le « vol + séjour » touristique peut aussi permettre de faire tourner une économie locale qui coûterait encore plus cher si elle n’était prévue que pour le séjour de scientifiques. Pourquoi donc refuser l’argent du privé s’il peut aider à développer la base martienne et à faire fonctionner la recherche ?! Cette remarque me semble d’autant plus pertinente que les « touristes » qui, au-delà de l’orbite basse terrestre, viendront passer un séjour nécessairement long sur Mars, 18 mois (imposé par les contraintes synodiques), devraient très souvent y « faire quelque chose » ou y « tenter quelque chose », qui pourrait s’avérer utile et profitable à tous (ils y seront d’autant plus incités qu’ils auront payé très cher ces « vacances »). Le « touriste » pourrait être un cinéaste mais il pourrait être aussi un futur entrepreneur venu tester une idée, un concept, dans un environnement extrême ou il pourrait être un « étudiant-chercheur » de haut niveau voulant bénéficier de l’environnement intellectuel exceptionnel de la communauté martienne (concentration extrêmement forte de personnes à la pointe de chacune des nombreuses technologies nécessaires à la vie sur Mars…et sur Terre). Je trouve que la proposition de Monsieur Droneau de vouloir restreindre l’accès à l’espace à des « spécialistes » est extrêmement élitiste, arrogante et contraire aux intérêts même de la Science. Tout le monde ayant une motivation suffisante et capable de réunir les moyens financiers nécessaires (les siens propres ou ceux de ses sponsors), ce qui va d’ailleurs ensemble, doit pouvoir avoir accès à l’Espace pourvu que son projet ne soit pas nuisible de façon évidente à l’intérêt commun (il devra quand même y avoir un comité ou conseil pour accepter les candidatures, ne serait-ce que pour des raisons de sécurité ou de nombre de « places » limitées).

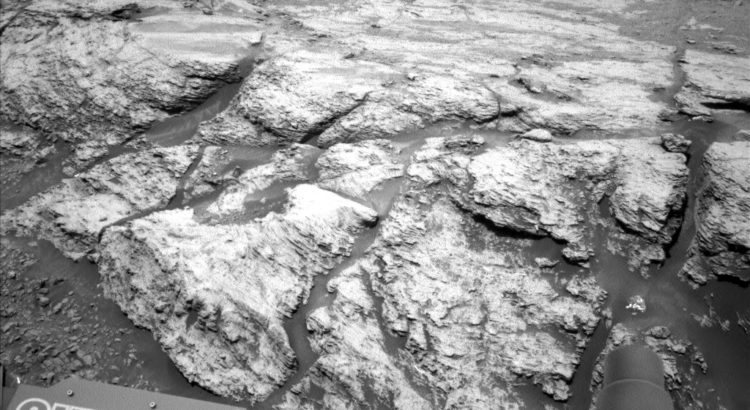

Ma troisième réponse est que oui Mars pourrait être pour les Terriens une planète-B. Il est évident que seule une infime partie des Terriens pourront s’établir sur Mars. Non pas 100 dans 200 ans mais plutôt 1000 dans 20 ans, contrairement à ce que pense Philippe Droneau, mais de toute façon un nombre très, très inférieur à la croissance annuelle actuelle de la population mondiale. Mais ces quelques personnes pourraient emporter avec elles, conserver et faire fructifier la quintessence de notre civilisation ; ce n’est pas rien ! Cela vaut un effort et même de diffuser quelques tonnes de CO2 supplémentaires dans l’atmosphère terrestre. Dans le cas d’un cataclysme survenant sur la Terre ce serait pour nous tous, ceux qui seraient partis et ceux qui n’auraient pas pu ou voulu partir, une seconde chance (intellectuellement pour les seconds). Dans le cas d’une continuation heureuse de notre civilisation sur Terre, ce serait un enrichissement potentiel, le nouveau milieu accueillant la vie suscitant forcément des innovations profitables également à la vie sur Terre…Tout ceci pourvu évidemment que l’on laisse suffisamment de temps aux nouveaux Martiens pour s’installer et, dans le cas de l’hypothèse catastrophiste, qu’ils aient eu suffisamment de temps pour acquérir une autonomie leur permettant de survivre si la civilisation terrestre est détruite. Ce ne sera pas demain! En attendant, du fait de la stimulation du milieu, la présence d’une colonie humaine sur Mars nous apportera des innovations intéressantes pour tous, Martiens et Terriens, dans le domaine du transport, de la durabilité, du recyclage, de la productivité agricole, du traitement économe de l’environnement, de son contrôle microbien, etc…

Alors dans ce contexte, je ne vois vraiment pas quel est le « coût éthique » auquel fait allusion Philippe Droneau. Je trouve que sa vision de notre futur, de nos besoins et de nos devoirs, est extraordinairement étriquée et conventionnelle. Un vrai scientifique devrait faire confiance à nos capacités d’innovations et d’adaptation ; ce ne semble pas être son cas. C’est fort regrettable pour quelqu’un chargé de la diffusion de la Science auprès du Public.

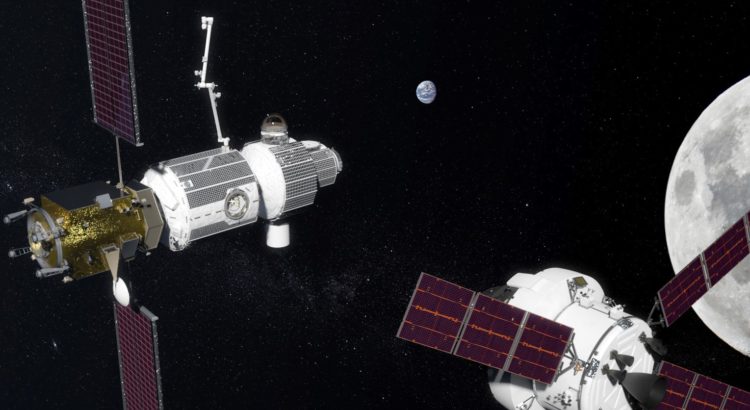

Image de titre: le premier étage Super-Heavy et son Starship au décollage dans l’atmosphère terrestre; le premier étage va jusqu’aux ailerons (à la base du Starship). crédit SpaceX.

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: