Aller sur Mars n’est pas une fin en soi, c’est entreprendre de vivre en dehors de notre planète avec l’espoir que cela conduise notre espèce humaine à fleurir un jour partout dans l’Univers, repoussant au plus loin possible notre mort certaine. Nous le valons bien !

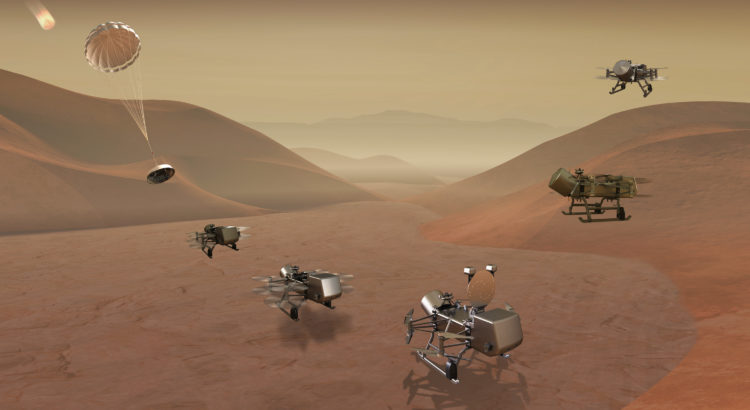

Beaucoup de critiques de l’exploration de Mars par vols habités, disent que les robots « feraient beaucoup mieux » ou, pour les plus conciliants, « aussi bien » que l’homme, le travail de recherche scientifique que certains partisans de cette exploration humaine mettent en avant pour justifier leur exigence d’aller sur place. Ils ont tort car l’homme avec le robot aurait beaucoup plus d’efficacité que le robot sans l’homme. N’oublions pas le problème de la distance entre les deux planètes qui impose absolument, du fait de la finitude de la vitesse de la lumière, un décalage (« time-lag ») entre le moment où l’on donne un ordre à une machine et le moment où il est exécuté et ensuite celui où l’on reçoit l’information sur ce qui a été exécuté. Mais là n’est pas le vrai problème et la vraie motivation du vol habité car on est bien obligé pour les « terres » plus lointaines que Mars de recourir aux seules machines et on obtient quand même des résultats intéressants même s’ils le sont moins et qu’on les obtient plus lentement que si ces machines étaient « accompagnées ». Non, le vrai problème est que la seule exploration scientifique pour l’accroissement de nos connaissances ne nous fait pas nécessairement « sortir de notre berceau » comme le disait le fondateur de l’astronautique, Konstantin Tsiolkovsky au début du XXème siècle et que ce que nous voulons, nous les « Martiens-terrestres », c’est bien que l’humanité sorte de son berceau.

Cela ne veut pas dire que nous voulons demain que des hordes de Terriens en surnombre sur leur planète s’embarquent pour la planète Mars, la « terraforme » et la couvre de maisons (on dit des « habitats »), d’usines et de routes, pour le simple plaisir de continuer ailleurs ce que nous faisons sur Terre et de détruire Mars comme nous avons déjà pas mal endommagé la Terre (bien que la trajectoire semble aujourd’hui infléchie par une prise de conscience générale). Ce n’est pas si simpliste et de toute façon ce ne serait pas possible car le transport coûtera toujours cher et les « facilités de vie », absolument nécessaires compte tenu des conditions extrêmes imposées par l’environnement martien, ne seront pas si « faciles » à construire et qu’il faudra beaucoup de temps pour le faire.

Non ! Ce qu’on peut envisager c’est une lente progression de notre installation sur Mars et, au début du moins, une sélection très exigeante des candidats pour y participer. Il faudra en effet que les gens soient d’abord compétents car le « support-vie » de toute vie sera extrêmement coûteux et on ne paiera que le voyage de ceux qui seront indispensables au fonctionnement de la « Cité ». Il faudra qu’ils soient aussi ingénieux, adaptables et inventifs car ils devront faire face à toutes sortes de situations inévitablement imprévues avec des moyens limités sans pouvoir recourir à l’aide matérielle de la Terre. Il faudra aussi qu’ils aient un caractère d’acier, non parce qu’ils seront « loin de la Terre » mais parce qu’il sera capital de faire face avec sang-froid à ces problèmes sans être inhibés par leurs difficultés ou les dangers qu’ils impliquent. Et il faudra encore que la personne qui bénéficie de la sélection ait un sentiment de responsabilité qui dans tous les cas la pousse à donner en retour un service aussi bon que ses capacités lui permettent ; ce sera absolument indispensable au fonctionnement de la colonie puisque, la population étant très réduite, très peu sinon lui seul, pourront le fournir.

Mais cette installation sur Mars ne pourra pas être simplement une prouesse technologique. Elle le sera indubitablement mais si elle n’était que cela, elle ne pourrait pas avoir de continuité dans la longue durée. C’est sans doute en partie la raison pour laquelle l’aventure lunaire a été sans lendemain (à ce jour). Ce que nous voulons c’est que les hommes que nous enverrons sur Mars soient des fondateurs avec une vision. Cette vision c’est celle qu’avec Carl Sagan on peut faire germer puis cultiver dans son esprit en se retournant vers la Terre quand on s’en éloigne, en réalisant que toute l’humanité, passée et présente, est là sur ce pâle petit point bleu. Cela peut donner le vertige et cela générer sans doute de l’inquiétude si ce n’est de l’angoisse mais cela peut aussi donner de la fierté et de la force. Comment ne pas être fiers de certains, nombreux, accomplissements de l’homme et comment accepter que tout ce qu’on a créé de sublime sur Terre puisse disparaître un jour du fait de la vulnérabilité de ce petit point bleu ou plutôt de sa cognosphère* qui sur une période très brève, quelques milliers d’années, infime fraction de temps au regard des 4,567 milliards d’années de notre histoire planétaire, s’est développée à sa surface. Comment accepter qu’un jour personne ne puisse plus ressentir l’émotion et les sentiments suscités par la musique de Vivaldi, un poème de Baudelaire, une tragédie de Shakespeare, la lecture des Evangiles, celle de l’Odyssée ou simplement la beauté d’un coucher de soleil sur une dune plantée d’ajoncs au bord de la mer avec à ses côtés la femme qu’on aime (vous avez le droit de remplacer les miennes par vos propres justifications, selon votre sensibilité et votre culture) ?!

*ensemble des individus conscients et communicants.

C’est donc notre devoir en temps qu’êtres humains de porter cette flamme pour la conserver aussi longtemps que nous le permettront nos forces, comme nos ancêtres préhistoriques portaient leurs braises dans un petit réceptacle de pierre et de bois dur et qu’il nourrissait sans cesse de peur qu’elles ne s’éteignent. Ce ne sera pas facile et ce ne se fera pas sur un chemin rectiligne et déjà tracé. A chaque époque cela dépendra des progrès de notre technologie et de notre envie de continuer à vivre.

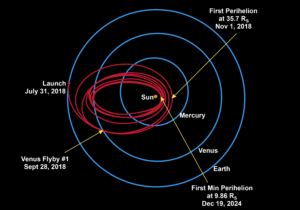

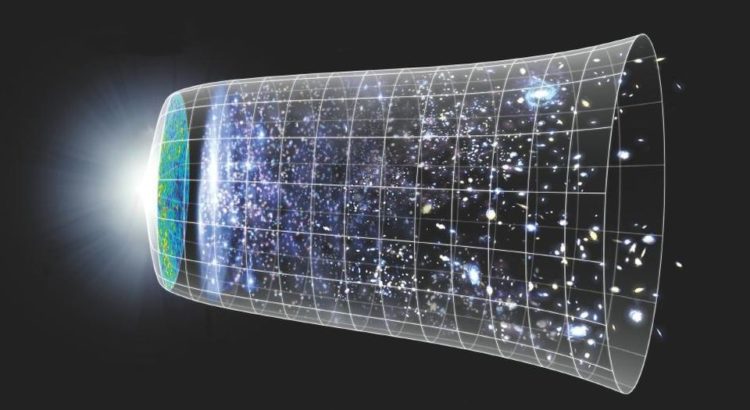

Cela doit commencer par Mars parce que tout simplement c’est la seule planète où l’on puisse envisager aujourd’hui de le faire compte tenu de la distance accessible malgré le danger des radiations et compte tenu des ressources qu’elle peut nous offrir. Mais cela ne doit pas s’arrêter à Mars. Un jour nous pourrons aller plus loin et il faudra aller plus loin. Un jour nous pourrons construire des îles de l’espace comme en a rêvé Gerard O’Neill et il faudra construire ces îles. Un jour nous pourrons nous embarquer pour aller ailleurs, vers une autre planète orbitant une autre étoile dans la ceinture habitable de notre Voie Lactée et peut-être un jour, inimaginable aujourd’hui, encore plus loin et il faudra aller toujours plus loin. Nous serons partout, toujours plus inventifs et plus créatifs. Il y aura des échecs et il y aura des drames mais il y aura aussi des merveilles et mille fleurs écloront dans l’espace. Nous avons un potentiel extraordinaire. Nous sommes sans doute ce que la Nature a produit de plus complexe, de plus intelligent et de plus sensible (et si ce n’est pas exact, nous devons faire « comme si »). Nous avons donc un devoir vis-à-vis d’Elle (certains l’appellent autrement et je n’ai pas de problème avec ça) et vis-à-vis de tous ceux qui nous ont porté jusqu’ici, et nous devons absolument honorer cette obligation.

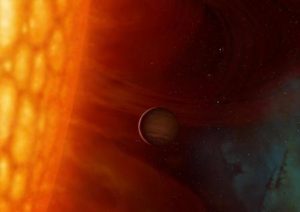

Alors un jour « nos descendants » qui ne seront sans doute plus « humains » au sens où nous l’entendons aujourd’hui car à chaque génération l’évolution empoigne nos gênes animés par l’ardente nécessité de survivre et de transmettre, et les triture et les transforme dans ce processus complexe sinon étrange que l’on comprend mieux maintenant avec la prise de conscience de la force homéostatique qui l’anime, mais « nos descendants » tout de même dans la mesure où ils auront gardé l’aptitude aux sentiments que nous leur aurons transmis et qui auront essaimé sur une multitude de planètes, chacune devenue autonome et différente, se retourneront vers leur passé qui se perdra dans les brumes du Temps et, à la lueur du magnifique spectacle de notre Soleil transformé en géante rouge et enflée au maximum avant de se transformer en nébuleuse planétaire, ils auront une pensée pour leur planète d’origine disparaissant dans son enfer et ils nous diront merci pour leur vie et leur Liberté.

NB: Maintenant que nous connaissons mieux notre environnement spatial (qu’il y a, disons, une cinquantaine d’années) on peut dire qu’il y a sans doute des planètes-B (et que Mars pourrait faire l’affaire), mais qu’il n’y a pas d’« Humanité-B ». Je développerai bientôt ce thème.

Image de titre : nébuleuse ouverte NGC2818 (à environ 10.000 années-lumière de “chez nous”). Notre Soleil en fin de vie s’effondrera sur lui-même et rejettera gaz et matière en une coque plus ou moins sphérique qui se dilatera peu à peu autour de lui dans l’espace. Crédit NASA, ESA et l’équipe Hubble Heritage (STScl/AURA).

Image ci-dessous : pale petit point bleu : photo de la terre prise en 1990 par la sonde Voyager 1, à environ 6,5 milliards de km (distance moyenne de Pluton), crédit NASA/JPL-CalTech. C’est cette photo qui a inspiré le titre du livre de Carl Sagan, « Pale Blue Dot : a vision of the human future in Space » (1994). Le point bleu se trouve dans la bande la plus claire, à 40% du bas de l’image.

Image ci-dessous (vue d’artiste): Dans 5 milliards d’années, notre Soleil enflé en géante rouge et la Terre; crédits : Mark Garlick/HELAS

Elon Musk a fait le point hier, Samedi 28, sur son projet Starship + SuperHeavy. Je vous donne le lien vers sa présentation sur Youtube. Je suis heureux de constater que nous sommes tout à fait dans le même état d’esprit qu’exprimé dans l’article ci-dessus. NB: la présentation qui dure 43 minutes a été suivie de questions / réponses (à partir de 48’50). Enjoy!

https://www.spacex.com/webcast

Pour (re)trouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: