Selon Robert Zubrin*, fondateur et président de la Mars Society, l’administration du président Trump perpétue l’erreur des administrations précédentes en n’assignant pas un objectif clair à la politique d’exploration spatiale. Il semble en outre que cette politique soit basée sur une mauvaise compréhension du contexte spatial, dans ses difficultés et ses opportunités. Ce faisant elle risque malheureusement de passer à côté de l’avantage considérable que lui offrent les innovations technologiques de SpaceX. Le résultat c’est que les Américains risquent de dépenser en vain pour n’aller nulle part.

Voici la traduction de ce qu’écrivait le Dr. Zubrin le 2 Mars 2018 dans la National Review, revue très lue et très influente dans les milieux conservateurs américains :

Un programme spatial axé sur un objectif?

Le 12 février, l’administration Trump a dévoilé son projet de budget pour la NASA. Alors que le financement total de 19 milliards de dollars n’est pas très différent des niveaux approuvés par les administrations Obama et Bush, ce projet a réussi à porter l’incohérence de la pensée de l’agence spatiale à des niveaux vraiment remarquables.

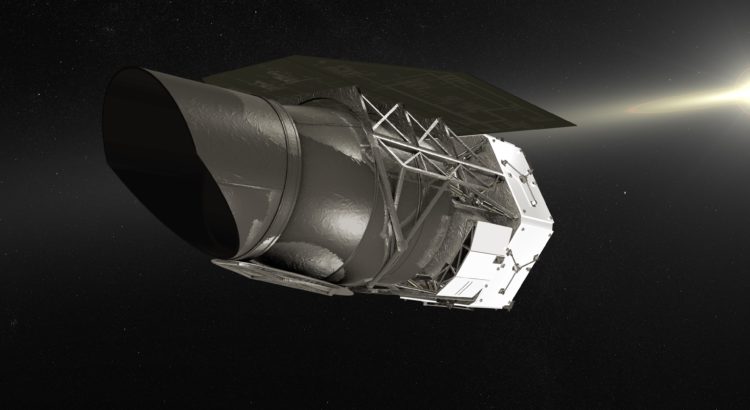

Un exemple particulièrement frappant d’illogisme est donné par la décision de l’administration d’annuler le télescope d’exploration infrarouge à grand champ (WFIRST) tout en persévérant vers la réalisation d’une station spatiale en orbite lunaire baptisée « Deep Space Gateway ».

WFIRST* est un télescope spatial de 2,4 mètres de diamètre doté de capacités supérieures à celles de Hubble, qu’on aurait pu mettre en orbite pour un budget exceptionnellement bas de 3 milliards de dollars en raison du don à la NASA par le « National Reconnaissance Office », d’un satellite espion excédentaire. Il permettrait des découvertes révolutionnaires d’exoplanètes et pourrait potentiellement révéler la vérité sur la nature de l’énergie sombre supposée être la cause de l’expansion de l’univers, et sur de nombreuses autres interrogations dans le domaine de l’astrophysique. Il a été approuvé et fortement soutenu en tant que priorité absolue par tous les conseillers scientifiques entourant le gouvernement.

*NdT: voir aussi mon article précédent “WFIRST pourrait nous éclairer sur le mystère de l’énergie sombre“

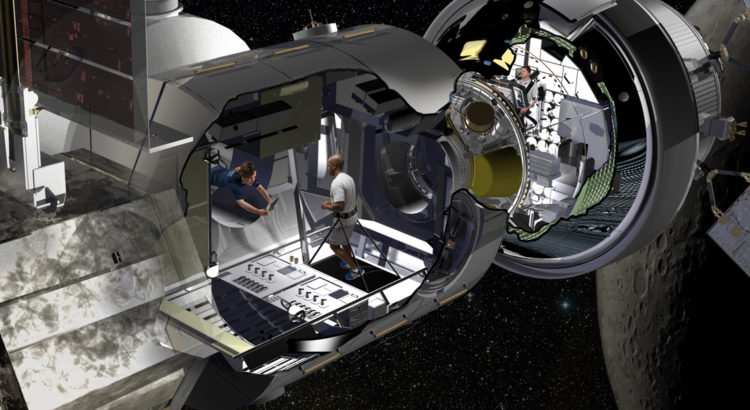

Deep Space Gateway (récemment rebaptisé « Lunar Orbital Platform-Gateway »), quant à lui est un lamentable gâchis qui coûtera plusieurs dizaines de milliards de dollars et ne servira à rien. Nous n’avons pas besoin d’une station en orbite lunaire pour aller sur la Lune, sur Mars ou sur les astéroïdes proches de la Terre. Nous n’en avons besoin pour aller où que ce soit.

En orbite lunaire il n’y a rien à faire, rien à utiliser, rien à explorer. Il est vrai que l’on pourrait faire fonctionner des rovers à la surface de la Lune depuis son orbite mais l’argument selon lequel installer une telle station serait utile pour éliminer le délai de deux secondes nécessaires pour les contrôler depuis la Terre, est absurde. Nous sommes sur le point d’avoir des voitures autonomes sur Terre qui pourront gérer les conditions de circulation à New York et à Los Angeles et il y a beaucoup moins de trafic sur la Lune !

Pourtant, le problème avec Deep Space Gateway est beaucoup plus grave que le gaspillage de décennies en temps et de dizaines de milliards de dollars en bon argent. Le problème le plus profond est la forme de pensée qu’il représente.

Les programmes d’astronomie et d’exploration planétaire robotiques de la NASA ont réalisé des exploits qu’on peut qualifier d’épiques parce qu’ils sont axés sur des objectifs. En revanche, depuis la fin d’Apollo, le programme de vols spatiaux habités de la NASA n’a visé aucun objectif. En conséquence, ses réalisations ont été négligeables.

Si le but est de construire une base lunaire, elle devrait être construite sur la surface de la Lune. C’est là que se trouve la Science, c’est là que se trouvent les matériaux de protection contre les radiations, et c’est là que se trouvent les ressources nécessaires pour fabriquer les ergols propulseurs et autres choses utiles. Le meilleur endroit pour la construire serait à l’un des pôles car il y a dans ces régions de petites zones où la lumière du soleil est accessible tout le temps ainsi que des cratères dans l’obscurité perpétuelle où la glace s’est accumulée. Une telle glace pourrait être électrolysée pour fabriquer des propulseurs à hydrogène-oxygène, pour alimenter les véhicules de retour sur Terre ainsi que des « hoppers » balistiques qui fourniraient à l’équipage de la base un accès pour exploration à la plus grande partie du reste de la Lune. (Ndt : un hopper est un petit transporteur fonctionnant par réaction de gaz chauffés par panneaux solaires mis au point par Robert Zubrin pour usage sur Mars, à partir du CO2 de l’atmosphère).

L’administration Trump dit qu’elle veut retourner sur la Lune mais ses actions ne sont pas compatibles avec cet objectif. En plus de ce projet farfelu en orbite lunaire, son budget affecte 7,5 milliards de dollars au cours des trois prochaines années à la préparation du premier vol du Space Launch System (SLS) alors que nous avons déjà le Falcon Heavy de SpaceX qui peut emporter en orbite 70% de la charge utile du SLS pour un dixième du coût. Les mêmes fonds, s’ils étaient dépensés pour développer des atterrisseurs et des véhicules ascensionnels, pourraient permettre un retour sur la Lune dans quatre ans et des missions humaines sur Mars dans huit ans.

La situation est vraiment ironique. Avec le succès de Falcon Heavy l’Amérique pourrait dès maintenant être positionné sur une base solide pour une véritable percée dans l’exploration spatiale. L’argent disponible est suffisant. Ce qui manque, c’est une direction intelligente. Nous n’irons jamais sur Mars si nous laissons notre programme de vols spatiaux habités avancer au hasard.

La NASA n’est pas allée sur la Lune en incorporant dans son programme tout ce que les industriels et leurs représentants mettaient en avant comme éléments qui pourraient éventuellement servir. Elle y est allée en prenant fait et cause pour un objectif clair et en agissant en conséquence.

Au lieu de saboter les efforts scientifiques sains et motivés de la NASA, l’administration Trump devrait se concentrer sur une direction pareillement rationnelle, appliquée à un programme de vols spatiaux habités qui reste scandaleusement à la dérive.

Fin de traduction.

lien vers l’article en Anglais: https://www.nationalreview.com/2018/03/nasa-lunar-space-station-unnecessary-space-flight-plans-lack-purpose/

Commentaire :

Robert Zubrin exprime très clairement l’inanité du projet de station spatiale en orbite lunaire. On dirait que le concept sort de la tête de personnes qui ne connaissent rien au sujet traité. Si le projet est exécuté, le seul résultat sera d’avoir une deuxième Station Spatiale Internationale (ISS), à la différence que cette fois ci les astronautes qui l’occuperont seront beaucoup plus exposés aux radiations spatiales puisqu’elle sera située hors de la protection du champ magnétique terrestre. L’administration américaine voudrait dégoûter le grand public des missions spatiales habitées qu’elle ne s’y prendrait pas autrement. Par ailleurs ignorer les travaux et le succès d’Elon Musk est incompréhensible puisque, en même temps, SpaceX est un fournisseur apprécié de la NASA pour ses ravitaillements de la Station Spatiale et a prouvé avec son Falcon Heavy sa capacité à placer en orbite terrestre la charge utile que le SLS est incapable de lever alors qu’il est en préparation depuis le double de temps. Cette incohérence tend à confirmer que ce qui préoccupe l’administration américaine c’est avant tout de soutenir l’emploi dans l’industrie spatiale quel que soit l’objet auquel cette industrie applique ses efforts (et notamment la mise au point du SLS). C’est assez lamentable.

*NB : Robert Zubrin détient un MS en Aéronautique et Astronautique et un Ph.D en Ingénierie nucléaire (Uni. de Washington). Il a été membre de l’équipe de la société Lockheed Martin (constructeur des fusées Apollo) chargée de développer ses stratégies d’exploration spatiale. Il a été également “senior engineer” chez Martin Marietta Astronautics (successeur de Lockheed Martin) en charge du développement des concepts avancés de missions interplanétaires. Il a fondé la Mars Society en 1998 et a écrit de nombreux ouvrages sur la faisabilité des missions habitées sur Mars (notamment « The Case for Mars » en 1995). Il est aujourd’hui entrepreneur indépendant : président de Pionneer Astronautics, société de recherche et développement dans les technologies aérospatiales et à ce titre fournisseur de la NASA ; président de Pionneer energy, société de recherche et développement dans le pétrole et les ergols de synthèse. A ce titre il a mis au point une technologie écologique innovante de récupération des gaz non traités lors de l’exploitation des gaz de schistes.

Image à la Une: Projet “Lunar Orbital Platform Gateway”, vue d’artiste, crédit Lockheed Martin.

Image ci-dessous: concept ESA d’une base lunaire avec habitat réalisé en impression 3D avec du régolite lunaire (vue d’artiste, credit ESA):