Les quasars, « quasi-stars »* ressemblent à des étoiles mais ce ne sont pas des étoiles, un peu comme la reine des abeilles n’est pas l’essaim mais son cœur, avec d’autant plus d’« animation » qu’on l’approche. Les quasars sont « tout simplement » des galaxies dans une forme primitive, une organisation quasi-révolue de la matière dans l’espace. Ils n’existent plus qu’exceptionnellement dans notre environnement « proche » mais nous pouvons toujours en admirer les lumières puissantes venues de la très lointaine époque où ils étaient abondants, du fait de cette puissance même et du fait que lorsque nous regardons loin nous regardons aussi dans la profondeur du temps.

*Plus précisément « QUAsi Stellar Astronomical Radiosource ».

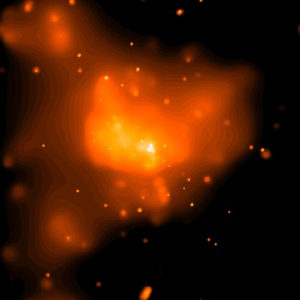

Les quasars sont les sources les plus lumineuses de l’Univers. Leurs jets de gaz expulsés orthogonalement et de part et d’autre de leur disque d’accrétion (voir plus loin), atteignent des vitesses relativistes (proches de celle de la lumière). Ils émettent des radiations dans toute la gamme des longueurs d’ondes (avec un fort décalage vers le rouge parce qu’ils sont très lointains), des ondes radio, aux rayons gamma en passant par les infrarouges, la lumière visible, les ultraviolets, les rayons X. Dans les ondes visibles ils ont une luminosité de l’ordre de 1040 W (bien au-delà de la « limite d’Eddington » qui est un seuil d’équilibre) mais c’est dans le domaine des ondes radio qu’ils ont d’abord été remarqués. Ils se distinguent des autres événements violents comme les novæ ou les supernovæ en ce qu’ils ne sont pas ponctuels, des explosions, mais des phénomènes d’une certaine durée.

Dans les années 1950 on se posait des questions sur l’origine d’émissions radios très fortes dont on ne parvenait pas à observer la correspondance en ondes visibles. En 1962 Cyril Hazard de l’Université de Sydney, réussit par une utilisation astucieuse du radiotélescope de Parkes, en Australie, avec l’aide de son directeur John Bolton, à percevoir pour la première fois (dans la constellation de la Vierge) la source lumineuse d’un de ces phénomènes. On le nomma « quasar » (avec l’identifiant « 3C273 », désormais une référence), du fait de son apparence stellaire tout en ayant conscience que « quelque chose n’allait pas » pour le classer dans cette catégorie. Le diamètre angulaire de l’objet bien qu’hyper-lumineux était en effet extrêmement petit, quelques jours-lumière seulement, mais beaucoup plus gros qu’une étoile « normale ». La progression vers la compréhension du phénomène fut lente car il est toujours difficile de changer ses paradigmes face à « quelque chose » de nouveau.

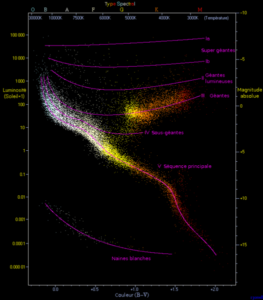

Le premier « éclairage » fut donné par Maarten Schmidt de l’Observatoire du Mont Palomar à qui Cyril Hazard avait communiqué les caractéristiques de sa découverte. Marteen Schmidt comprit que le spectre de la lumière reçue était celui de la raie de l’hydrogène bien qu’elle soit fortement décalée vers le rouge (le « redshift » était de 0,158). Cela indiquait une forte vitesse d’éloignement donc une distance très grande (2,44 milliards d’années-lumière, à comparer aux 13,7 du « fond diffus cosmologique », « CMB »), à laquelle on n’avait pas l’habitude d’observer quoi que ce soit (rappelez-vous que « la toile de fond » de l’Univers, le CMB cité ci-dessus, n’a été observée qu’en 1964). Compte tenu de sa luminosité apparente (12,9) on constata que la source devait émettre autant de lumière (magnitude absolue -26,7) que plusieurs centaines de galaxies comme notre Voie-lactée.

Il fallut ensuite comprendre ce qui pouvait être à l’origine de cette énorme puissance. On apprit beaucoup par le nombre des observations (nous avons aujourd’hui un catalogue de plus de 100.000 quasars) qui permit des comparaisons et des généralisations. D’abord on constata que si les quasars étaient très anciens, ils n’étaient pas présents au tout début de l’Univers observable (métallicité faible mais non nulle de leur spectre). Leur nombre était très important il y a 10 à 9 milliards d’années puis il diminua très rapidement. Il n’y en a pratiquement plus aujourd’hui. Plus précisément il n’y en a plus qu’un seul pour un million de galaxies dans un rayon d’un milliard d’années-lumière alors qu’ils étaient un pour mille il y a 10 à 9 milliards d’années. Par ailleurs il apparut que ces objets avaient une très forte variabilité. Ils peuvent être durables (plus que toute période d’observation à ce jour) mais leur activité peut aussi varier fortement sur des périodes très courtes (quelques jours ou même quelques heures), leur seul point commun étant en fin de compte leur puissance d’émission dans leur faible taille.

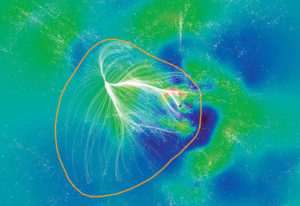

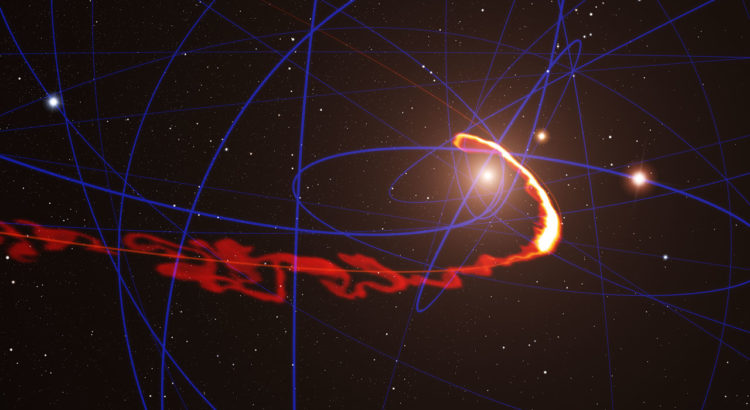

L’explication la plus logique qui fut progressivement apportée (dans les années 1980), est que les quasars sont des trous noirs supermassifs dans des galaxies très denses ou plutôt dont les masses de matière proches du centre (c’est-à-dire celles qui peuvent être déstabilisées par la force gravitationnelle du centre) sont très denses. On les identifie maintenant aux plus actifs des « noyaux actifs de galaxie » (ou « AGN » pour « Active Galaxy Nucleus »). Leur « activité » viendrait d’une concentration de matière autour du trou noir telle que ce dernier y pourrait trouver, sur la durée, une « nourriture » plus qu’abondante. Le gaz serait, sous influence gravitationnelle du trou, accéléré à une vitesse voisine de celle de la lumière, créant d’intenses champs magnétiques et un rayonnement colossal. Au CalTech, Donald Lynden-Bell a calculé qu’un trou noir supermassif pouvait convertir en radiations jusqu’à 40% de la masse de matière aspirée. Le phénomène est cumulatif ; l’absorption de matière gonfle la masse du trou noir et lui permet d’attirer par gravité, davantage de masse dans un disque d’accrétion qui tourne de plus en plus vite autour de son centre, comme de l’eau dans un évier. Maintenant tous les AGN peuvent ne pas avoir une « activité » suffisante pour s’exprimer en quasar. On en distingue de plusieurs types selon ce critère : radiogalaxies, galaxies de Seyfert, blasars, magnetars. Il y a aussi des AGN relativement « tranquilles » (« radio-quiet »). Pour qu’un AGN devienne quasar, il faut un trou noir supermassif (force d’attraction du trou et vitesse du disque d’accrétion) et beaucoup de matière absorbable à proximité du trou. La quantité de matière se mesure en masses solaires et on estime qu’il faut que le trou-noir consomme au moins une étoile de type solaire par jour pour apparaître comme un quasar. C’est la matière de ce disque d’accrétion, chauffée par la rotation rapide causée par sa chute sur le trou, les fusions d’étoiles et leur déchirement lorsqu’elles sont sur le point d’être absorbées, qui seraient la source des radiations dégagées dans le faisceau (le « jet ») émis de part et d’autre du plan du disque d’accrétion. La partie active du noyau a une taille égale à la durée des variations d’intensité du quasar (la lumière ayant une vitesse limitée) et on constate qu’il n’excède pas quelques semaines lumières. Ces dimensions sont cependant énormes comparées à notre système solaire (les sondes Voyagers qui sont sorties récemment de l’héliosphère ne sont qu’à environ 18 heures-lumière mais l’étoile la plus proche est à 4,3 années-lumière).

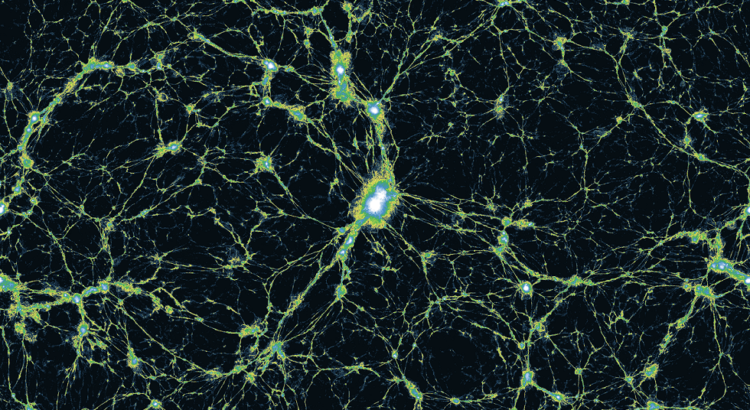

Cette explication permet de comprendre aussi pourquoi les quasars étaient plus nombreux autrefois. La densité de l’Univers, plus contracté (dans lequel l’expansion n’avait pas atteint les effets constatés dans l’Univers d’aujourd’hui), facilitait les collisions de galaxies, donc les concentrations. Par ailleurs la matière de certains des nuages de gaz qui s’étaient condensés et qui avaient « allumé » leurs étoiles se trouvaient encore à proximité de leur centre (un peu comme la matière dans un système planétaire avant que l’étoile ait « nettoyé » par ses radiations l’espace dans son environnement immédiat).

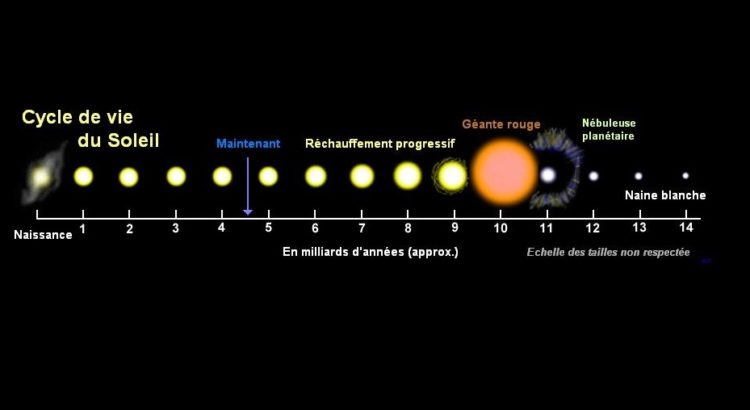

On en est venu à penser que beaucoup de galaxies ont été des quasars à une période initiale de leur vie. Compte tenu du nombre de galaxies, du nombre de trous-noirs selon les différentes époques et de l’importance de la matière non-absorbée par les trous noirs, on estime que la « phase quasar » d’une galaxie massive pourrait durer en moyenne une dizaine de millions d’années et pas plus de 100 millions d’années.

C’est la réflexion tout autant que l’observation qui a permis la compréhension du phénomène et cela « interpelle » concernant les capacités de l’intelligence artificielle. En effet l’IA repose sur l’utilisation des données. Plus de données permet une analyse plus fine d’un phénomène. Ainsi dans le cas présent, on peut comparer les résultats, constituer des catégories de rayonnements et des catégories de sources de ces rayonnements, remarquer grâce à l’accumulation des données que le phénomène a eu lieu statistiquement beaucoup plus fréquemment il y a 10 et 9 milliards d’années que récemment. Mais c’est tout. L’image des quasars est trop petite pour être résolue par nos télescopes. Concevoir que les quasars ne sont pas des étoiles mais de la matière stellaire dans un disque d’accrétion autour d’un trou noir supermassif, requière de « penser en dehors de la boîte ». Le robot doté d’une IA ne le fait pas, il permet à l’homme de le faire.

Au-delà de savoir qu’ils existent, les quasars présentent beaucoup d’intérêt pour la connaissance de l’Univers. Ils sont comme des balises dans l’espace profond ou comme des jalons dans l’obscurité pour remonter toujours plus loin. De par leur masse, ils peuvent servir de loupes gravitationnelles à des objets encore plus distants. Récemment, grâce à l’instrument MUSE installé sur le VLT, on a constaté que les plus anciens d’entre eux permettaient d’éclairer les masses sombres des premières galaxies ou plutôt des protogalaxies qui n’avaient pas encore formé d’étoiles, à la sortie des « âges sombres ». Dans le passé, ils ont pu être de forts éléments perturbateurs de leur environnement, donc de concentration de nuages de gaz, et de création d’étoiles (comme les supernovæ aujourd’hui). Dans le monde d’aujourd’hui on comprend que les trous-noirs centraux supermassifs, comme celui de notre Voie-lactée, ont probablement dans leur prime jeunesse, été des AGN et peut-être des quasars. Si c’est le cas, peut-être est-ce le cas de toutes les galaxies spirales. Enfin on peut penser que la diminution de leur nombre au fil de l’Histoire, vient confirmer l’accélération de l’expansion de l’Univers (moins de fusions de galaxies aujourd’hui).

Liens et références :

https://www.pourlascience.fr/sd/astronomie/les-quasars-trous-noirs-en-action-1183.php

https://fr.wikipedia.org/wiki/Quasar

https://www.physicsandastronomy.pitt.edu/cyril-hazard

Ciel et espace n°568, décembre 19 / janvier 20 : « On a vu les premières galaxies », par Guillaume Langin

https://en.wikipedia.org/wiki/Active_galactic_nucleus

Illustration de titre: un quasar primordial, crédit Wolfram Freudling et al. (STECF), ESO, ESA, NASA

Image ci-dessous: structure d’un AGN: credit: CC BY-SA 3.0, https://commons.wikimedia.org/w/index.php?curid=46857319

Pour retrouver dans ce blog un autre article sur un sujet qui vous intéresse, cliquez sur: