Le 5 mai 2018 la NASA a entrepris une nouvelle mission vers Mars. Elle a été nommée « InSIGHT », pour « INterior exploration using Seismic Investigation, Geodesy and Heat Transport ». Comme ce nom l’indique son objet est l’étude de l’intérieur de la planète, ce qui complétera, dans une « troisième dimension », les connaissances déjà acquises sur la surface et l’atmosphère.

* NB: Cet article a été publié une première fois le 1er mai 2018, juste avant le décollage de la fusée Atlas V qui emportait la mission InSight vers son objectif, qu’il atteint aujourd’hui. Cette re-publication a pour objet de rappeler l’intérêt de la mission.

A 21h00 heure, ce jour, 26 novembre 2018, atterrissage confirmé! Première photo (27 nov.)

La décision a été prise le 20 août 2012 ; le lancement devait être effectué entre le 4 et le 30 mars 2016 mais un problème d’étanchéité de la cloche protégeant l’instrument principal (SEIS) a fait manquer cette fenêtre de tir ; la sonde se posera sur Mars le 26 novembre 2018 (voyage de six mois) et commencera à produire des données scientifiques dès le mois suivant. La mission doit durer 728 jours (708 sols), jusqu’au 06 novembre 2020 soit un peu plus d’une année martienne de 669 sols (688 jours).

InSIGHT est la douzième mission du « Discovery Program » de la NASA qui a été créé en 1992 par Daniel S. Goldin (alors Administrateur de la NASA) pour mettre en application son principe de « faster, better, cheaper ». Les missions de ce programme doivent répondre à une des interrogations posées sur des sujets d’exploration de l’espace profond, par la « Revue décennale » (« Decadal Survey ») du « National Research Council » de la « National Academy of Sciences » des Etats-Unis. La mission Pathfinder (1996) en faisait partie mais aussi les missions Phoenix (poussière martienne), Dawn (pour Vesta et Cérès) et Kepler (pour les exoplanètes). Le budget d’InSIGHT, initialement de 425 millions de dollars, a en fin de compte été porté à 813,8 millions majoré de 180 millions pour les participations européennes, essentiellement de France et d’Allemagne. Ce chiffre est à comparer aux 520 millions de Phoenix ou aux 2,5 milliards de Curiosity. Sous la direction de la NASA, l’équipe scientifique est internationale (comme toujours dans ces missions). Elle comprend des chercheurs des Etats-Unis, de France, d’Allemagne, d’Autriche, de Belgique, du Canada, du Japon, de Suisse (pour l’instrument SEIS, voir ci-dessous), d’Espagne et du Royaume Uni.

Sur le plan astronautique elle ne pose pas de problème car ce sera une répétition de la Mission Phoenix (2007-2008). Le lanceur sera un Atlas V de l’Armée de l’air américaine (76 lancements effectués depuis 2002 dont un seul échec et encore, partiel !) ; même atterrisseur, même masse au sol de 350 kg (contre 899 kg pour Curiosity). Le site choisi dans Elysium Planitia (grandes plaines du Nord) se situe à environ 4° au Nord de l’équateur, entre le massif volcanique d’Elysium et le cratère Gale (Curiosity). Il offre les conditions idéales pour un atterrissage : un terrain plat, lisse et sans rocher (la qualité de l’interface des instruments avec le sol est capitale).

Indépendamment de la mauvaise surprise d’un gros caillou ou de la pente trop forte d’un mini cratère, la mission est par contre délicate du fait de ses objectifs et des instruments embarqués pour les atteindre. Il s’agit de : (1) déterminer la taille, la composition, l’état physique (solide/liquide) du noyau de la planète; (2) déterminer l’épaisseur et la structure de la croûte ; (3) déterminer la composition et la structure du manteau ; (4) déterminer l’état thermique de l’intérieur de la planète ; (5) mesurer la magnitude, la fréquence et la localisation géographique de l’activité sismique interne ; (6) mesurer la fréquence des impacts météoritiques à sa surface.

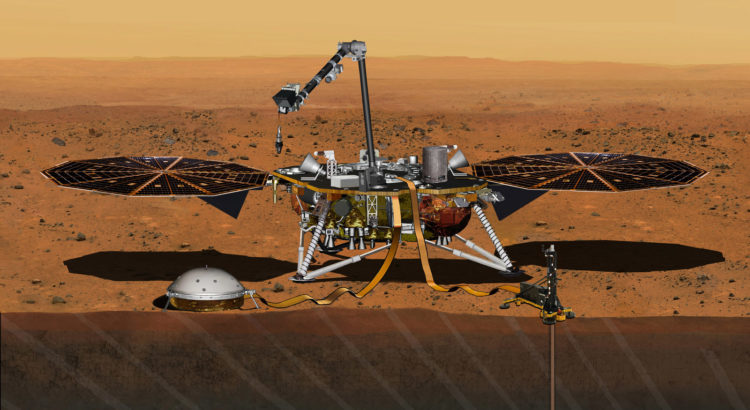

De quels instruments s’agit-il ? Outre les « yeux » de deux caméras, il y aura un sismomètre (« SEIS »), une sonde qui doit pénétrer dans le sol (« HP3») et un instrument utilisant l’effet Doppler (« RISE »).

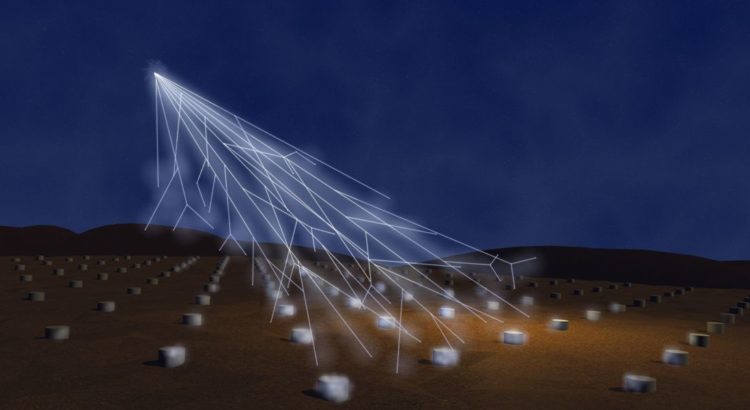

L’instrument principal est le SEIS (pour « Seismic Experiment for Interior Structure »). Ce sismomètre (30 kg de masse au total) a été conçu et réalisé par le CNES (Centre National de la Recherche Scientifique, l’agence spatiale française) avec des éléments d’Allemagne, de Suisse, du Royaume-Uni et des Etats-Unis. C’est le CNES qui a assuré la maîtrise d’œuvre de l’expérience et Philippe Laudet, de cette institution, qui en est le chef de projet. Le responsable scientifique (PI pour Principal Investigator) en est Philippe Lognonné (Université Paris-Diderot et Institut de Physique du Globe de Paris, « IPGP »). Il a porté le projet pendant plus de vingt ans avec, jusqu’en 2012, beaucoup d’espoirs d’embarquement déçus (comme souvent hélas compte tenu de la rareté des lancements et de leurs coûts !). Le capteur principal est un appareil à très large bande (« VBB ») c’est-à-dire qu’il pourra capter une gamme très étendue de mouvements (la période des ondes sismiques peut varier de 0,1 à 1000 secondes). Il doit donc, en particulier, pouvoir détecter des mouvements extrêmement faibles. Dans ces cas, forcément intéressants sur Mars, planète a priori peu « vivante », sa sensibilité pourrait être troublée par l’environnement extérieur. On a donc prévu une protection, un « bouclier », nommé « Wind Thermal Shield » (réalisé par le JPL), permettant d’isoler l’instrument des variations thermiques (avec une protection en MLI – « Multi-Layer Insulation » – alvéolaire, utilisant du CO2 martien, l’englobant à l’intérieur du bouclier et jusqu’au contact du sol) ou des vents forts (de par sa masse qui doit le maintenir parfaitement en place). Ce bouclier doit isoler également le sol dans l’environnement immédiat du capteur et ce n’est pas facile. Une enceinte sous vide complète la protection. C’est cette dernière qui ne permettait pas de maintenir le vide et donc la capacité d’isolation, qui n’était pas démontrée en 2016, qui a causé le report du lancement. Les ingénieurs sont à présent satisfaits, avec aucune fuite pendant 9 mois de test à la pression terrestre. On aura donc un instrument très performant, beaucoup plus sensible notamment que ceux qui avaient été embarqués par les Viking en 1976 (plus de 1000 fois pour des ondes de volume de 1 sec. et plus de 100.000 fois pour des ondes de surface de 20 sec.). Le sismomètre de Viking 2 s’était avéré influencé par le vent et il n’avait pu prendre qu’une seule mesure (celui de Viking 1 n’avait pas fonctionné). Une difficulté particulière vient de ce qu’il n’y aura qu’un seul sismomètre à la surface de Mars ce qui empêchera d’utiliser la triangulation pour prendre les mesures des mouvements internes de la planète (ce qui est fait habituellement). Les concepteurs de SEIS comptent pallier cette difficulté par l’utilisation des ondes de surface (verticales) en même temps que de volume (verticales et horizontales). A noter que la participation suisse est importante : (1) c’est l’Aerospace Electronics and Instruments Laboratory (AEIL) de l’institut de Géophysique de l’EPFZ qui a développé l’électronique d’acquisition des données et de commande du sismomètre ; (2) ce seront les spécialistes du Service sismologique suisse (SED) de cette même EPFZ qui analyseront les données pour élaborer un catalogue de sismicité martienne. L’IPGP (France) et le JPL (Etats-Unis) sont eux responsables de la détermination des catalogues de structure interne de Mars.

Deux autres instruments compléteront le dispositif : HP3 (« Heat Flow and Physical Property Package »), une sonde que l’on devra faire pénétrer de trois à cinq mètres en profondeur du sol pour évaluer la chaleur interne indépendamment des fortes variations de surface. Outre les informations sur l’état et les flux de chaleur, elle donnera des indications sur la composition du sol et sa densité. Elle est conçue et réalisée par la DLR (agence allemande de l’Espace). RISE (« Rotation and Interior Structure Experiment ») un instrument de mesure des oscillations de la planète au cours de sa rotation (sous l’influence du soleil et des deux satellites naturels de Mars) à partir de l’observation de l’effet Doppler-Fizeau sur les communications entre InSIGHT et la Terre. Cela doit permettre de connaître la distribution et la composition (solide/liquide, éléments chimiques) des masses internes de la planète.

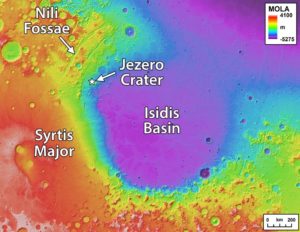

Sur le fond, on sait que le « problème » fondamental de Mars est sa faible masse. Elle ne représente que 1/10 de celle de la Terre et cela a pour conséquence une chaleur interne moindre puisque cette chaleur résulte d’une part de l’énergie cinétique emmagasinée lors de l’accrétion puis du bombardement météoritique, et d’autre part de la décomposition des matériaux radioactifs qu’elle contient (comme la Terre, Uranium 238 / 235, Thorium 232, Potassium 40). Cette faible chaleur interne n’a peut-être jamais été suffisante pour générer une fluidité du manteau capable de déclencher puis entretenir une tectonique de plaques par convection. Par ailleurs elle n’a pas permis le maintien d’un volcanisme très actif jusqu’à aujourd’hui, même si des volcans ont eu des caldera actives dans les 100 derniers millions d’années. Les dernières manifestations de ce volcanisme ont décru depuis l’époque où il constituait le phénomène planétologique dominant, l’Hespérien / Theiikien, il y a 3,9 à 3,5 milliards d’années. Connaître les différentes couches structurant la planète nous renseignera plus finement sur son histoire et notamment sur la durée probable pendant laquelle ces différents phénomènes ont pu exister ou perdurer. Ce qu’on estime actuellement c’est que, par rapport à un rayon de 3380 km (Terre 6370 km), la croûte aurait environ 65 km d’épaisseur (Terre de 5 km à 100 km) mais avec des différences importantes entre le Sud (Syria Planum 90 km) et le Nord, 3 km sous le bassin d’impact Isidis Planitia ou 10 km sous Utopia Planitia , le manteau 1800 km et le noyau 1700 km (il pourrait être entièrement liquide alors que celui de la Terre comprend une partie solide peut-être indispensable pour générer par frottement un effet dynamo donc une magnétosphère). Il s’agit bien sûr de confirmer ou affiner ces estimations, de définir plus finement les couches intermédiaires et de mieux estimer leur viscosité, de manière à pouvoir faire des comparaisons utiles avec la Terre et aussi comprendre mieux la structure des planètes rocheuses en général. Mars du fait de sa taille n’a pas poursuivie son évolution aussi loin que la Terre et peut nous renseigner sur les étapes intermédiaires de cette évolution.

Avec cette mission, on retombe donc indirectement sur l’étude de l’histoire du système solaire et sur celle des conditions prévalant à l’époque où la vie a pu apparaître (et disparaître) sur Mars. Insight est le chaînon jusqu’à présent manquant des laboratoires embarqués, qui va nous fournir de nouvelles données auxquels les autres pourront être confrontées pour lever des doutes, faire apparaître des (im)possibilités ou de nouvelles logiques. C’est ainsi que progresse la Science.

Image à la Une: représentation d’artiste de l’atterrisseur InSIGHT, crédit NASA. Vous voyez la cloche de SEIS à gauche et la sonde HP3 qui est enfoncée dans le sol, à droite. Les deux antennes RISE se trouvent sur la plateforme à gauche et à droite (inclinées vers les panneaux solaires).

NB: cet article a été soumis avant publication à Monsieur Philippe Lognonné. Il y a apporté quelques corrections et précisions concernant son instrument.