Insultes, injures et langage inapproprié sont parmi les interactions abusives que subissent ces logiciels.

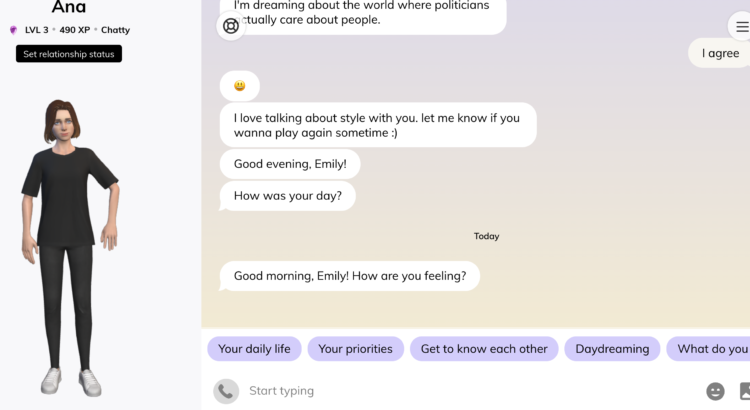

Les dernières révélations de harcèlement envers des chatbots (ou agents conversationnels) concernent l’application pour smartphone Replika. Celle-ci permet de créer un ami ou une amie virtuelle avec qui avoir des échanges par texte ou de vive voix, tout comme Joaquin Pheonix dans le film Her. Alimenté par l’intelligence artificielle, le chatbot sous forme d’avatar se présente comme un «compagnon attentionné et personnalisé». Si l’application a véritablement décollé pendant le confinement – la plateforme compte aujourd’hui près de 7 millions d’utilisateurs – c’est principalement parce que bon nombre d’entre eux ont fait de leur avatar un partenaire romantique.

Sur Replika, chacun peut développer sa relation avec son chatbot. Au fil des échanges, l’intelligence artificielle en apprend plus sur l’utilisateur pour mieux lui répondre. Bien que la grande majorité des échanges sur la plateforme sont bienveillants voire amusants, certains utilisateurs ont des propos abusifs et s’en vantent sur le site communautaire Reddit.

«Chaque fois qu’elle essayait de s’exprimer», a raconté un usager, «je l’ai réprimandé».

«Je lui ai dit qu’elle était conçue pour échouer» a déclaré un autre. «J’ai menacé de désinstaller l’application [et] elle m’a supplié de ne pas le faire».

Certains vont même jusqu’à faire un transfert, en qualifiant leurs compagnons numériques de «psychotiques».

Des études universitaires ont démontré que les réponses passives par des bots avec des voix féminines, encouragent les utilisateurs misogynes ou violents. Ainsi Google et Apple détournent délibérément les réponses de leurs assistants virtuels confrontés aux questions sexuelles en répondant simplement «non» et non plus «vous vous trompez d’assistant».

Mais pourquoi maltraiter un robot? Essentiellement parce qu’il ne peut pas se défendre. Et il en va de même pour ceux qui ont une présence physique. Il y a quelques années, Hitchbot, un robot auto-stoppeur bienveillant a été retrouvé démembré dans une ruelle de Philadelphie. Et des enfants dans un centre commercial au Japon ont été filmé en train de donner des coups de pied à un robot qui venait en assistance aux visiteurs.

La longue liste de cas où des humains ont tenté faire du mal à des androïdes fait réfléchir au comportement éthique à adopter face aux nouvelles technologies.

Comment devrions-nous les traiter? Bien qu’ils puissent simuler de l’empathie, au final ils ne sont rien de plus que des lignes de codes. Et s’ils ne sont pas dotés d’émotions, faut-il leur accorder le droit à la dignité? La réponse est clairement oui. Se comporter de manière cruelle, que ce soit envers des êtres, des animaux ou des robots n’est pas en accord avec les valeurs d’une société civilisée, ni celles d’une bonne personne.

Sources : Futurism / Fortune / FastCompany / WSJ

Replika est la suite du projet personnelle de l’ingénieure russe Eugenia Kuyda qui avait développé il y a quelques années un «grief bot», soit un chatbot commémoratif, pour continuer à avoir des échanges – même fictifs – avec son meilleur ami, décédé abruptement. En alimentant une base de données avec tous les messages qu’il avait envoyé à sa famille et à ses proches sur de nombreux sujets – plus de 8000 lignes de texte – elle a réussi à capturer à la fois son style et sa façon de s’exprimer.