Le Temps consacrait récemment un paragraphe sur le féroce affrontement entre Washington et Pékin sur le plan technologique. Avec Xavier Comtesse, nous y consacrions également un article dans l’Agefi pour souligner les efforts scientifiques (brevets, nombre de chercheurs, etc.), dépenses militaires (778 milliards de dollars au pays de l’Oncle Sam contre 252.3 milliards au pays de Mao) et dispositions politiques (p.ex. la loi sur la réduction de l’inflation ou Inflation Reduction Act IRA en anglais aux États-Unis et le capitalisme d’État en Chine) des deux puissances. Sur ce thème encore, des chercheurs de l’Institut Jacques Delors ont publié un excellent travail qui traite de cette nouvelle rivalité entre les deux premières économies mondiales.

En guise d’introduction, ces derniers écrivent: “Les distorsions de concurrence du capitalisme d’État chinois provoquent de tels déséquilibres systémiques au sein du système libéral d’économie de marché que les États-Unis ont décidé de s’affranchir de certaines règles multilatérales au nom de la sécurité nationale. À leur tour, ils adoptent des mesures coercitives et une stratégie industrielle aux caractéristiques chinoises qui s’appuie sur des subventions massives et des clauses de contenu local. Les annonces agressives se multiplient du côté de Washington et de Pékin. La course au leadership technologique s’accélère en même temps qu’une réorganisation de la mondialisation qui peut aussi bien conduire à la coexistence de blocs rivaux qu’à une escalade de mesures de rétorsion et une fragmentation des chaînes de valeur mondiales.”

Outre les aides d’État et son régime communiste qui promet la croissance, la République Populaire de Chine a, au tournant du millénaire, mis l’accent sur sa politique expansionniste qui incitait ses entreprises à investir à l’étranger. Mieux connue en anglais en tant que Go Out Policy (ou Going Global Policy), elle a permis à des nombreux acteurs chinois d’acquérir des sociétés internationales, notamment européennes, et ce très activement avec la crise de la dette européenne à la fin des années 2000 (possibilité pour la Chine de racheter la dette sous forme d’obligations et de participer à des projets d’infrastructures). Dès lors, de l’autre côté de nos frontières, la gourmande Chine en plein essor a pris des participations dans des infrastructures clés telles que l’entreprise d’énergie portugaise Energias de Portugal EDP (21% détenus par Three Gorges, 2011), l’aéroport de Heathrow à Londres (10%, 2012), le port du Pirée à Athènes (rachat par Cosco, 2016), etc. En outre, les exemples d’acquisition de fleurons européens par des groupes chinois sont légion: le constructeur automobile suédois Volvo (Zhejiang Geely, 2010), le fabricant de pneus italiens Pirelli (ChemChina, 2015), l’entreprise de robots industriels allemande Kuka (Mideas, 2015), etc.

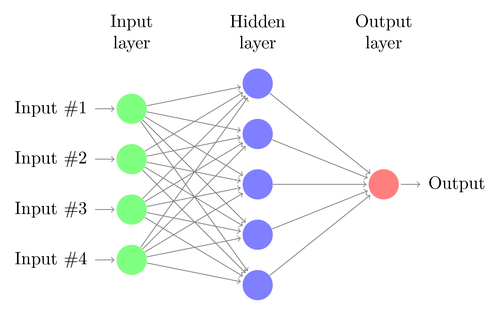

Ces participations et main-mises sur des entreprises sont des exemples concrets de la volonté tentaculaire de la Chine à s’étendre dans des secteurs qui contribuent à son propre développement. La pays chérit également des secteurs tels que l’intelligence artificielle (IA), les télécommunications 5G, l’informatique quantique, l’agriculture, les transports, etc. où elle investit massivement aussi bien à l’interne qu’à l’externe, directement ou indirectement (p.ex. Huawei et le réseau 5G en Allemagne). En parallèle, les États-Unis renforcent leur capacités en aérospatiale, défense, semi-conducteurs ou encore des techniques de fabrication de pointe pour n’en citer que quelques uns. En outre, la robotique, la biotech et bien d’autres sont des domaines d’importance nationale pour maintenir une dominance à l’échelle du globe. America First ou Make China Great Again: des slogans qui justifient le contournement des règles du libéralisme économique afin de renforcer leurs capacités d’innovation, de production, d’approvisionnement, etc. qui répondent aux enjeux nationaux.

“Les bénéfices que tirent les États-Unis de cette intégration économique avec la Chine s’arrêtent là où leur leadership économique mondial est remis en cause par le rapide essor économique de la Chine.”

Dans ce contexte géopolitique tendu aux budgets pharaoniques, comment la Suisse se positionne-t-elle?

Le Temps relayait déjà la question en 2018 lors de la publication de chiffres relatifs aux investissements chinois en Europe: faut-il y voir une apologie libéralisme, garanti par le maintien d’emplois et d’investissements, ou au contraire y déceler une menace pour nos intérêts stratégiques (transfert de savoir-faire, accès privilégié à des technologies, contrôle d’entreprises, sécurisation de chaînes d’approvisionnement, etc.)? L’annonce du rachat en 2016 de Syngenta par le groupe chinois ChemChina pour 42 milliards de francs n’a pas laissé pas de doutes quant à la volonté de l’Empire du Milieu de garantir son accès à un portefeuille de produits chimiques de premier ordre et de semences protégées par des brevets pour améliorer la production agricole nationale. Un an auparavant, Swissport était cédée au groupe HNA pour renforcer ses activités dans le secteur aérien en forte expansion au niveau national (2.73 milliards de francs). Pour sécuriser des approvisionnements en énergie, on peut encore citer les cas d’Addax (7.24 milliards de dollars par Sinopec en 2009) et de WinGD (CSSC en 2016).

Les Etats-Unis ne sont pas en reste au niveau des acquisitions, notamment en ce qui concerne les start-ups helvètes. En 2022, selon le Swiss VC report, 22 jeunes pousses ont été acquises par des entreprises américaines, soit presque un tiers de toutes les ventes de sociétés (type start-ups). Deloitte rapporte également qu’en 2022, le nombre d’acquisitions réalisées par des entreprises étrangères est resté plus ou moins inchangé à un niveau élevé de 58% (98 sur 169), et que pas moins de 65% des acquéreurs de PME suisses étaient des entreprises européennes, les autres venant principalement des États-Unis (23%).

Exclue du programme de recherche européen Horizon2020 (plus de 95 milliards d’euros pour la période 2021-2027) suite à sa décision unilatérale d’arrêter les négociations sur l’accord cadre avec l’Union Européenne en 2021, la Suisse tente de se maintenir aux premières places auxquelles elle est habituée dans des classements d’innovation, de compétitivité, de R&D, etc. S’étant forgée vers et par l’extérieur, la Suisse isolée semble continuer dans une voie où elle subit plus qu’elle ne définit sa propre destinée. Trop petite et prônant un dialogue qui n’est plus vue comme une réponse appropriée à des guerres en tout genre, elle joue maladroitement des coudes mais cela ne l’empêche pas d’avoir les pattes engluées, voire piétinées par des ogres qui contrôlent l’ordre mondial, sans parler des ressources (p.ex. gaz, pétrole, terres rares).

Le multilatéralisme et le libre-échange ont du plomb dans l’aile, victimes d’une modulation des règles en fonction des intérêts des géants de ce monde. La concurrence devient de moins en moins équitable en considérant d’une part les aides d’états et d’autre par les restrictions aux exportations qui obéissent toutes deux à des considérations géopolitiques. Le drapeau du parti communiste chinois prend un sens bien métaphorique: la faucille prélève les avancées technologiques pour mieux frapper avec le marteau dans la foulée? L’enclume nord américaine met décidément la Suisse à rude épreuve… Au nom de l’ordre mondial et des sécurités nationales, suivez les guides!