On excusera ces anglicismes, qui sont inhérents au domaine. Ils ont d’ailleurs été partagés par les co-fondateurs de SwissCognitive lors d’une récente table ronde. Ce «WEF de l’intelligence artificielle» était de passage à Boston afin de promouvoir l’excellence de la Suisse dans ce domaine.

Puisque la puissance de calcul de nos ordinateurs a été démultipliée, notamment grâce à la loi de Moore et aux fameux processeurs NVIDIA, on lit désormais que les Google, Facebook, Microsoft, IBM ou encore Amazon de ce monde s’aguerrissent au machine learning. Malgré la fréquence d’utilisation de ce mot à la mode, reprenons les définitions que d’aucuns qualifieront de trop simplistes.

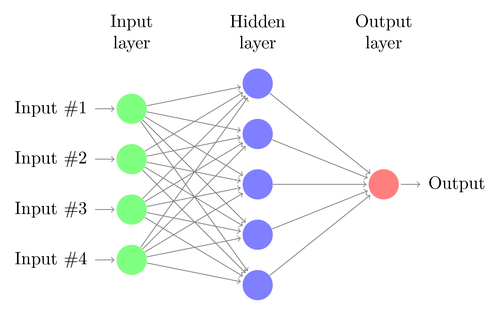

Avec le machine learning, il s’agit, d’une certaine façon, d’enseigner aux ordinateurs à apprendre, voire de leur montrer comment apprendre par eux-mêmes. Descendant dans les catégories, vient ensuite le supervised learning, qui s’applique à un ensemble de données labelisées, par différenciation au unsupervised learning. Une autre technique computationnelle, appelée deep learning, implique l’utilisation d’un très large réseau neuronal («neuron») afin de reconnaître des structures dans un grand nombre de données. De temps à autre, surtout dans le milieu des véhicules autonomes, on mentionne aussi le reinforcement learning: pendant la phase d’entraînement, un logiciel de contrôle répète une tâche un très grand nombre de fois et modifie légèrement ses instructions à chaque essai; il met à jour ses valeurs à mesure que le système apprend.

Ces avancées représentent un pas de géant par rapport aux désavantages d’une intelligence artificielle (IA) «basique» qui requiert un nombre important de règles à implémenter dans le code informatique et «qui montre rapidement des faiblesses lorsque l’on travaille avec des cas aux limites», comme le rappelle Phil Greenwald des Laboratoires de l’Innovation d’Harvard.

Vers une intelligence inexplicable

On comprendra que l’on est entré dans une phase où la machine se programme par elle-même: on pourrait donc parler d’une intelligence augmentée! Et cela peut donner quelques frissons, d’excitation quand on pense aux fantastiques opportunités que cela offre, mais aussi de peur si l’on pense à des scénarios post-apocalyptiques robocopiens. Une des facettes intrigantes du fonctionnement de tels systèmes est qu’il n’y a pas de moyen clair pour les designer afin qu’ils puissent toujours expliquer la logique qui les a mené aux résultats. A l’instar des comportements humains, qui sont souvent impossibles à expliquer en détails, il ne sera peut-être pas possible de comprendre pleinement le fonctionnement de cette forme d’intelligence computationnelle. Comme le souligne le Prof. Clune de l’Université du Wyoming: «c’est peut-être la part ‘naturelle’ de l’intelligence. Si seulement une partie est sujette à une explication rationnelle, une partie est peut-être uniquement instinctive, ou subconsciente, ou insondable.» Certains experts pensent même que l’intelligence pourrait plus facilement émerger si les machines s’inspiraient de la biologie et apprenaient par le biais de l’observation et de l’expérience. D’autres, comme les chercheurs du MIT derrière l’idée de la «Machine Morale», pensent qu’un système qui agrège des points de vue moraux de différentes personnes «pourrait déboucher sur un système moralement meilleur que celui d’un seul individu.» Le professeur de droit James Grimmelmann de Cornell suggère même que «cela rend l’IA plus ou moins éthique, au même titre qu’un grand nombre de personne est éthique ou ne l’est pas».

Mais revenons à des considérations plus pratiques. Alors qu’IBM vient d’investir 240 millions de dollars dans un partenariat avec le MIT pour continuer ses recherches en IA, les récentes critiques à l’encontre de son outil Watson offrent un exemple criant de la difficulté à mettre l’IA au service de la santé. Dans une profonde analyse, le projet STAT du Boston Globe relève le côté boîte noire de la technologie: «actuellement, IBM Watson fournit des preuves à l’appui des recommandations qu’il suggère, mais n’explique aucunement de quelle manière il en est venu à proposer un traitement spécifique pour un patient donné.» Des spécialistes s’insurgent contre la confiance aveugle placée dans des résultats dont les données de base n’ont pas été comprises. Dans le monde de la santé, c’est un risque tentant: gain de temps, accès à des très larges bases de données, etc. Cependant, le monde est encore à un stade où la responsabilité personnelle prime, ce qui explique pourquoi le machine learning est encore utilisé de concert avec un médecin. Mark Michalski du MGH&BWH Center for Data Science relève qu’ «il est nécessaire d’établir une relation de confiance avec cette technologie disruptive dans une industrie très conservatrice.» Katherine Andriole, professeur en radiologie à la Harvard Medical School, pose la situation: «Il se passe beaucoup plus qu’une simple perception, qu’une reconnaissance de motifs: les radiologues font appel à leurs capacités cognitives.» Cela pourrait rapidement changer. Que l’on soit averti. Un exemple helvète: retinAI qui permet d’atteindre, grâce à l’IA, le niveau de professionnalisme d’un ophtalmologue pour la détection de glaucomes ou de dégénérescence maculaire liée à l’âge.

On retiendra un énorme point positif: l’IA nous fait entrer dans une ère «orientée vers les données», ce qui, à terme, nous permettra de prendre des décisions éclairées par la forces des faits.

Bonjour M. Labouchère,

Je vous invite à lire le livre “The Undoing Project” dont le sujet est l’étude de la prise de decision chez l’homme.

Il y’a un passage très intéressant concernant la radiologie:

Des chercheurs ont donné plusieurs photos de kystes à des radiologues qui devaient déterminer s’il s’agissait de cancer ou non. Les chercheurs se sont également amusés à mettre plusieurs photos 2x.

Les résultats ont montré que les praticiens n’etaient pas d’accord entre eux et parfois même ils donnaient 2 diagnostiques différents pour les photos identiques.

Les chercheurs ont montré qu’un simple algorithme obtenait de meilleurs résultats que le meilleur des radiologues.

Merci beaucoup pour cette suggestion de lecture – à n’en pas douter ce monde sera bousculé par les avancées de l’IA. Dans tous les cas, on sent que le conservatisme du domaine freine l’adoption de la technologie, notamment pour des raisons légales: qui prend la responsabilité? Passionnante évolution!

Comment la Chine applique l’IA au monde de la santé: à lire dans cet article du Digital Journal.

Et n’oublions pas les TPU qui connaissent un fort dévelopement technologique afin de rivaliser avec les GPU de NVIDIA cités dans l’article.