Depuis des dizaines d’années, la matière noire et l’énergie sombre hantent l’esprit des cosmologues du monde entier. Elles constitueraient l’essentiel de l’Univers et pourtant on n’a jamais pu les observer en direct, quelle que soit l’échelle à laquelle on se place. On n’en voit que les effets supposés. Pourquoi ? Nous sommes peut-être sur une fausse piste. Peut-être faut-il à nouveau revenir au réel, c’est-à-dire à ce que l’on voit ou, pour généraliser, ne considérer comme réel que ce dont on reçoit une onde ou un rayonnement. En quelque sorte peut-être faut-il laisser tomber ce qu’on pourrait considérer comme des épicycles modernes. La théorie de l’invariance d’échelle du vide, exposée par André Maeder a, en ce sens, le mérite de proposer de remettre élégamment l’église au milieu du village.

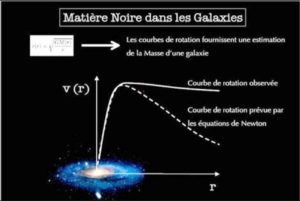

La matière noire et l’énergie sombre sont les explications données par le consensus (« modèle standard » de la cosmologie, dit « ΛCDM »*) pour des constatations embarrassantes : le mouvement des étoiles autour du cœur des galaxies est trop rapide, comme si une énorme masse cachée les enveloppait ; la vitesse de concentration des galaxies dans leurs amas est telle que la gravité parait être sensible à une énorme masse cachée au cœur de ces amas ; l’accélération de l’expansion de l’Univers qui se manifeste depuis quelques 6 ou 7 milliards d’années, parait être causée par une force étrange qui prolonge l’impetus donné par le Big-bang à l’origine de l’expansion de l’Univers il y a 13,8 milliards d’années et qui aurait dû petit à petit s’épuiser.

*Lambda Cold Dark Matter où Lambda (« Λ ») est la constante cosmologique, associée à l’énergie sombre.

Cependant ces explications, une masse et une énergie non observables directement mais seulement identifiables par leurs effets, ne sont pas satisfaisantes car, malgré les années et l’acharnement à les identifier directement, force est de constater que l’on n’y parvient toujours pas. Cette masse et cette énergie manquantes s’avèrent beaucoup plus élusives que l’antimatière et c’est bien gênant puisqu’elles constitueraient 95,1% de l’Univers ; toute notre matière perceptible, dite « baryonique », n’en constituant que 4,9%. Ne faudrait-il pas changer nos paradigmes ?

Un astrophysicien, André Maeder, professeur émérite à l’Université de Genève, a remis en question l’approche suivie depuis les années 1933 (Fritz Zwicky) et 1998 (Riess et al.), en expliquant ces phénomènes observés, sans introduire cette masse et cette énergie jamais détectées en direct. Sa théorie repose sur ce qu’il appelle l’« invariance d’échelle du vide ». Elle est très séduisante car si elle remet bien sûr en cause le modèle standard, ΛCDM, qui a introduit ces fantômes, elle ne suppose pas pour autant de remettre en cause les équations fondamentales des grands modèles de la cosmologie, seulement de les ajuster/préciser.

La démonstration faite par André Maeder est très compliquée à comprendre par les non spécialistes car elle suppose de solides connaissances en mathématiques. Je vais essayer d’en donner quelques éléments, suffisamment pour en faire ressortir les principes logiques.

Tout d’abord il faut savoir que l’« invariance d’échelle » est un concept de mathématiques et de physique selon lequel le comportement d’un système considéré est indépendant de l’échelle à laquelle on l’observe. On la trouve par exemple dans un ensemble fractal, à l’intérieur duquel, à tous les niveaux de « focus » on voit la même figure. C’est aussi le cas des équations de Maxwell en électrodynamique qui, en l’absence de charges et de courants, montrent la même propriété d’invariance d’échelle.

Mais il est aussi admis que cette invariance a des limites aux extrêmes, par exemple si on se situe au niveau des molécules élémentaires ou à celle du système entier qu’elles constituent. André Maeder insiste d’ailleurs bien pour dire qu’aux petites échelles (à commencer par l’échelle quantique) les lois de la Physique sont, dans l’Univers, dépendantes de l’échelle considérée mais, et c’est là où sa position diverge de celle du consensus, il nous montre que ce n’est plus nécessairement vrai à grande échelle. Plus précisément, ce qu’il veut démontrer c’est qu’à partir du moment où les lois de la relativité générale sont nécessaires pour expliquer ce que l’on voit, le vide spatial a les mêmes propriétés quelle que soit l’échelle à laquelle on observe. Derrière nous, le « cas extrême », vérifié, où la dépendance est constatée, c’est, pendant quelques petits milliards d’années après le Big-Bang, la période pendant laquelle la densité de la matière dans l’Univers était importante, soit Ωm > 0,01 (Ω = 1 lors du Big-Bang), Ω étant le facteur de densité, Ωm celui de la masse. A notre époque ce sont aussi toutes les régions de l’espace qui ne sont pas vides, comme le cœur des galaxies (mais pas leur périphérie).

En se fondant sur le principe de l’invariance dans ces conditions, André Maeder établit une relation entre la constante cosmologique ΛE et le facteur d’échelle λ du cadre invariant d’échelle. Il ne fait que préciser ΛE avec ce facteur λ ; tout le reste demeure inchangé et cela rejoint l’esprit dans lequel Albert Einstein lui-même avait introduit la constante dans ses équations, puisqu’on rapporte qu’il l’avait fait pour préserver l’invariance d’échelle de l’espace vide. Il est assez surprenant de constater que dans le modèle cosmologique standard, suite du travail d’Einstein, les propriétés du vide sont certes prises en compte mais d’une manière qui interdit cette invariance d’échelle.

Autrement dit, le cadre invariant d’échelle introduit par André Maeder offre une possibilité de concilier l’existence de ΛE avec l’invariance d’échelle de l’espace vide et André Maeder corrige ainsi une dérive allant contre le principe originel.

On voit l’effet de λ dans le graphe ci-dessous. La densité de masse, Ωm a un effet très fort mais pendant très peu de temps et cet effet est largement dominé par λ par la suite. Le fait est que pour Ωm = 0,3 l’effet n’est pas encore complètement éliminé. Mais après Ωm = 0,01, λ va vers l’infini extrêmement vite.

La leçon du Professeur Maeder a apparemment du mal à passer car la quasi-totalité des cosmologues continuent à « chasser » la matière noire et l’énergie sombre. Comme souvent on s’enfonce sur une mauvaise piste et on refuse de voir qu’on s’est fourvoyé car cela représente beaucoup de travail perdu, des années de recherche gâchées. Mais tôt ou tard la réalité reprend ses droits. On l’a bien vu avec Képler et sa loi des cycles (Astronomia Nova publié en 1609). Attendons et espérons que nos scientifiques modernes soient plus rapides pour se remettre en question que les nombreux successeurs d’Hipparque et de Ptolémée.

Illustration de titre : espace profond, photo Hubble. L’étoile est proche, les galaxies disques ou formes ovales sont évidemment lointaines. Les plus rouges sont les plus lointaines (effet Doppler-Fizeau résultant de l’expansion de l’Univers).

Lectures :

An alternative to the ΛCDM model: the case of scale invariance , publié dans The Astrophysical Journal, 834:194 (16pp), le 10 janvier 2017. doi:103847/1538-4357/834/2/194: https://iopscience.iop.org/article/10.3847/1538-4357/834/2/194

Un professeur genevois remet en question la matière noire (ATS, principale agence de presse suisse, Le Temps, 22/11/2017) : https://www.letemps.ch/sciences/un-professeur-genevois-remet-question-matiere-noire